Asistentes virtuales que funcionan, más cerca. Mucho más cerca.

El evento para desarrolladores de OpenAI de esta semana nos presenta un futuro con chatbots por doquier. La promesa de los agentes virtuales se cumplirá finalmente.

El primer Developer Day de Open AI ha removido la industria tecnológica como no se veía desde los tiempos de las legendarias keynotes de Steve Jobs. Quizá porque ChatGPT se está desperezando y esta semana nos mostró “el producto que puede llegar a ser”. Si queréis conocer todas las novedades que se presentaron, mejor leerlo en el blog de OpenAI, o aquí, o aquí, o verlo aquí en un vídeo resumido de 3’.

De todas las novedades, yo me centraré en la capacidad de crear asistentes a través de su API y chatbots específicos que han denominado -¡oh!- GPTs. Pero sobre todo, quiero explicar la tecnología subyacente, que sacudirá los cimientos de la experiencia de cliente. No es nueva. Lo que ha hecho OpenAI esta semana es facilitar el uso de un procedimiento técnico denominado RAG (que explico más abajo), y combinarla con su sistema de escritura de código y análisis de datos, Code Interpreter.

Democratizar el uso de estas tecnologías facilitando una interfaz sin necesidad de programación desencadenará una oleada de inversión, ya que poder probar y construir prototipos sin apenas esfuerzo atrae presupuestos empresariales (la dirección puede ver y tocar). Lo mismo que ocurrió con la IA generativa en el momento en que ChatGPT pusiera en mente (y manos) de todos lo que sólo unos pocos conocían desde que GPT-2 enseñara los dientes en 2019. Ahora veremos una ola de chatbots y asistentes virtuales como no habíamos imaginado antes. Habrá demasiados, ideas peregrinas, dinero tirado a la basura… Pero estamos asistiendo a un punto de inflexión y la forma en que las empresas se relacionan con sus clientes va a cambiar para siempre.

¿Qué es Retrieval Augmented Generation (RAG) y cómo lo implementa ChatGPT?

Los grandes modelos de lenguaje (LLMs) entienden el lenguaje natural y escriben gracias a una arquitectura de algoritmos denominada “transformer”, basada en redes neuronales que aprenden con palabras representadas con vectores numéricos. Estas redes neuronales (con millones de nodos estructurados en capas) son entrenadas con ingentes cantidades de textos, pidiéndole al modelo que prediga la siguiente palabra de una frase. Una vez “pre-entrenados”, pueden ajustarse mediante fine tuning para que el estilo de la escritura se acerque más al ámbito deseado (médico, legal, deportivo, ingeniería civil, etc). GPT y todos los LLMs (hay muchos) interpretan una instrucción en modo texto (prompt) y responden verosímilmente. Pero la respuesta, siendo estadísticamente válida gramaticalmente hablando, puede no ser verdad y a esto se le denomina alucinación. Y además, el LLM no busca información ni devuelve información específica y por eso no son adecuados, por ejemplo, como chatbots de atención al cliente. Y aquí es donde entra en juego la RAG.

La generación aumentada por recuperación (RAG siglas en inglés) es un marco de trabajo de IA que mejora la calidad de las respuestas generadas por el LLM basando el modelo en fuentes externas de conocimiento para complementar la representación interna de información.

OpenAI permite desde esta semana crear asistentes virtuales a través de su API y usar RAG. Sin conocimientos técnicos de ningún tipo, se puede acceder a tres funcionalidades:

Retrieval: aumenta el asistente con conocimientos externos a nuestros modelos, como datos de dominio propios, información sobre productos o documentos proporcionados por sus usuarios. Esto significa que no es necesario calcular y almacenar los embeddings (representaciones vectoriales) de los documentos, ni implementar algoritmos de fragmentación y búsqueda. La API optimiza la técnica de recuperación que se debe utilizar basándose en la experiencia de Open AI en la creación de recuperación de conocimientos en ChatGPT.

Code Interpreter: escribe y ejecuta código Python, puede generar gráficos y diagramas, y procesar archivos con datos y formatos diversos. Permite a los asistentes ejecutar código de forma iterativa para resolver problemas matemáticos y de código complejos, y mucho más.

Function calling: permite a los asistentes invocar funciones definidas por el usuario e incorporar la respuesta de la función en los mensajes del bot.

En este ejemplo, he creado un prototipo del asistente que ayudará a nuevos Rebels a entender nuestra cultura, estilo de liderazgo, valores y principios de comportamiento. Y que evolucionará seguramente, para ser un agente de gestión de conocimiento interno. Y con suerte, de reporting financiero :) Por ahora, me he limitado a subir nuestro libro Lidertarios y crear un chatbot que ayude a responder preguntas sobre valores y principios de comportamiento Rebel, junto a historias concretas que ilustran estos principios:

La confluencia de IA simbólica y generativa.

Escribí hace unos meses sobre la diferencia entre lo que se ha denominado IA simbólica y redes neuronales:

Una de las principales diferencias es cómo se produce el aprendizaje: en el razonamiento simbólico, las reglas se crean mediante la intervención humana, en el “deep learning” (redes neuronales) los algoritmos aprenden reglas a medida que se establecen correlaciones entre entradas y salidas. El primero es un enfoque “de abajo arriba”, son humanos los que establecen las reglas. Una tarea minuciosa que ha limitado la velocidad de desarrollo de este tipo de IA y su precisión, especialmente en tareas como la escritura (la traducción de textos) y otras funciones de creación de contenido. Sin embargo, en tareas deterministas como la creación de órdenes de compra venta en mercados financieros, la compra programática de publicidad, o el control automático de armamento, la IA simbólica tiene más sentido y lleva años en aplicación industrializada.

Cuando OpenAI habilitó plug-ins en marzo, Ben Thompson, probando el de Wolfram/Alfa (el sistema de resolución de matemáticas creado por Stephen Wolfram) dijo que era como darle un ordenador a ChatGPT. En cierto modo, se abría el camino para combinar los dos tipos de IA. Y se configuraba una herramienta mucho, mucho más potente. Ahora ChatGPT será un producto más útil, porque si no tiene una respuesta, se encargará de buscarla allí donde se encuentre, sea la wikipedia o una base de datos con estructura numérica que es capaz de analizar sobre la marcha.

Nueva forma de interacción entre marcas y clientes.

Aún queda mucho por recorrer. Estos sistemas aún alucinan, se equivocan y tienen límites artificiales de protección (guardrails en inglés) aplicados por sus creadores para evitar la generación de contenido inadecuado o maligno. Y todo ello complicará la creación de agentes más o menos autónomos.

Por otro lado, no es lo mismo crear un bot simpático para nuevos empleados, que un sistema real de gestión del conocimiento empresarial y menos aún, un bot de atención al cliente para Iberdrola que pueda resolver sin intervención humana una duda de un cliente. La API de Open AI facilita la labor a individuos y pequeñas organizaciones. Pero las grandes empresas tienen aún petabytes de datos en SQL, NoSQL, Binary, HDFS y otros formatos y requieren complejas BBDD contextuales, que puedan almacenar y recuperar diferentes tipos de datos utilizando capacidades de búsqueda híbridas (búsqueda léxica y semántica).

Romain Huet, responsable de la experiencia de los desarrolladores en OpenAI, describió el lanzamiento de la API de Asistentes como un "pequeño paso" hacia el futuro de los agentes de IA totalmente autónomos. A pesar de la humilde descripción, este "pequeño paso" tiene el potencial de transformar radicalmente nuestras interacciones cotidianas con la tecnología. Y con las empresas.

Lo haremos escribiendo en whatsapp o usando la voz ahora que Whisper es capaz de transcribir con mayor precisión que una persona. Y ahora que la voz artificial suena tan humana como la humana. Sabremos que interactuamos con un “autómata” pero nos dará igual, porque funciona. No es verdad que no nos gusten los sistemas automáticos de atención al cliente. Lo que no nos gusta es que fallen las automatizaciones. La experiencia de cliente va a cambiar para siempre. La búsqueda de información se hará más conversacional e intermediada por modelos de IA. Una nueva interfaz que, ahora sí, parece que funcionará.

El próximo domingo, vuelvo a tu buzón.

Fernando.

Hemos puesto de largo el Foro IA en MCX (Marketing, Comunicación y Experiencia de cliente). Impulsado por 18 ejecutivos MCX de grandes empresas y startups españolas para fomentar el aprendizaje y uso de herramientas IA. En foroia.es puedes registrar tu interés y dejar tu correo para estar informado de novedades y actividades del Foro.

Enlaces de interés para el profesional MCX.

Lecturas para mentes inquietas que buscan separar chicha de hype:

La biblia de la IA generativa, según CB Insights. “En este informe, utilizamos los datos de CB Insights -financiaciones de empresas tecnológicas, valoraciones, ingresos, relaciones comerciales, convocatorias públicas de resultados y perspectivas de los clientes- para ayudar a comprender lo que está ocurriendo en el mercado y los actores y tendencias a los que hay que prestar atención.” CBINSIGHTS, PDF

Para SEOs, me sopla nuestro equipo de Estudio34, enfocado en Performance Marketing que Google anuncia la expansión de la SGE (búsqueda generativa) a 120 países y cuatro idiomas (español, portugués, coreano e indonesio), lo cual parece indicar que la cosa va en serio :) En breve, se publicará un paper desde el foro IA sobre el futuro de las búsquedas. GOOGLE

Para los analistas de datos, me sopla nuestro equipo de Aukera, la división de analytics de Good Rebels, que GA4 SQL está disponible ya como Asistente en ChatGPT. Así que se pueden generar y personalizar consultas usando ChatGPT. Según ellos, el asistente ha sido entrenado para entender el esquema de exportación de GA4 BigQuery, así como los cálculos de métricas y dimensiones. X

Y para los diseñadores y UX/UIeros… me sopla nuestro equipo de Diseño y UX, Muskae, que Figma introduce FigJam, con IA generativa para su producto de pizarra online, y que promete ayudar a los diseñadores a evitarse la aburrida preparación de workshops y brainstormings. FIGMA, YOUTUBE

Si eres diseñador, la IA no viene a quitarte el trabajo... viene a llevarlo al siguiente nivel. Existe una falacia de coste desperdiciado para los diseñadores cuando se trata de IA. El coste desperdiciado: décadas dedicadas a perfeccionar sus habilidades. La falacia: que el uso de la IA hace que esas habilidades sean menos esenciales. La verdad es que la IA no tiene el ojo que tiene un diseñador. Puede que tenga acceso a un repositorio de trabajos creativos magníficos, pero carece de experiencia práctica real. No puede decir si algo tiene “buena pinta”. SUPERSIDE

La compra online le ha dado al consumidor más opciones que nunca, ofreciendo comodidad con sólo pulsar un botón. Pero hay un problema. Fakespot de Mozilla, utiliza IA para detectar reseñas falsas y estafas, algo que sólo se verá acelerado con los ChatGPTs del mundo. Un asistente que te acompaña durante la compra. No es tan sofisticado como un personal shopper (aunque todo se andará), pero te ahorra trabajo informándote sobre reseñas y cuestiones técnicas de los productos. MOZILLA

El LLM europeo Aleph Alpha ha levantado 500 millones de dólares en ronda de inversión. Y parece que puede haber hecho lobby en Alemania, junto a Mistral en Francia, para poner en jaque la ley IA de la UE que debería promulgarse antes de final de año (o callar hasta después de elecciones). ALEPH ALPHA, X

A Om Malik se le nota emocionado con el lanzamiento del Pin AI de Humane: un gadget nativo de IA generativa. Cuesta 700 dólares y una suscripción de 25 dólares al mes para acceder a una sim de T Mobile. Om piensa que es muy valiente lanzar un aparato al mercado siendo una startup (y lo es). Y cree que los tiros van por una interfaz minimalista de voz que además tiene cámara y proyecta un minúsculo haz de luz. Hay gente que se atreve a dejar por escrito sus dudas, aunque entiendo que a todo el mundo le da miedo sonar muy duro contra algo que podría marcar un nuevo “must” en términos de hardware como en su día hizo el iPhone. Pero, ¿es el próximo iPhone? A mí no me lo parece. Ahora bien, un par de iteraciones y GPUs más potentes y las cosas pueden cambiar rápido. OM, ARS TECHNICA, BUSINESS INSIDER

Vectara es una startup que ha calculado en un 3% el promedio de imprecisión factual (alucinaciones de los LLMs). Han elaborado un ranking de cuáles son los LLMs más imprecisos, y han lanzado una herramienta open source para medir el grado de alucinación o la divergencia con respecto a hechos verificables por parte de los LLMs. NEW YORK TIMES

Un fantástico análisis de a16z sobre cómo la IA generativa está cambiando el mundo de la música. Transformación de voz, introducción de funcionalidades IA en herramientas tradicionales, servicios de streaming. A16Z

La lista de lecturas IA de Barack Obama. LINK

Si escribes profesionalmente ya conocerás muchas de estas herramientas… Copy.ai, Jasper, ChatGPT… Pero no hay que dejar de probar. Yo he estado usando Lex y tengo en la lista Craft.do. The best AI tools to make you a better writer. FAST COMPANY

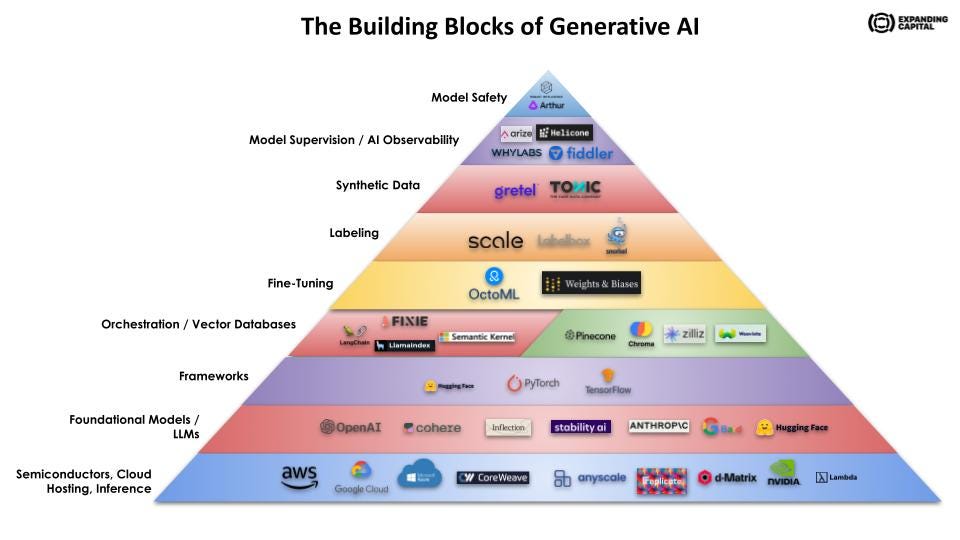

The building blocks of Generative AI. LINK

Gracias como siempre Fernando, qué mundo tan en ebullición todo lo de la IA y qué suerte poder vivirlo!