Cómo aprende mejor una IA: ¿viendo o leyendo?

Google anuncia Gemini 1.5. Open AI anuncia Sora (texto a vídeo). Y Meta anuncia V-JEPA (aprendizaje visual).

El Foro IA organiza este viernes 23 de febrero a las 12.00h una charla en el Ateneo de Madrid con José Luis Zimmerman, director de asuntos públicos de Meta. Hablaremos sobre las oportunidades y desafíos asociados al desarrollo y despliegue de la IA en nuestro país: impacto en la economía, sectores clave e implicaciones éticas y sociales. Será un placer veros si estáis por Madrid. ¡Y no dejéis de saludar en el cerveceo posterior!

Me hace especial ilusión este encuentro con José Luis. Nos conocemos de hace mucho y es un lujo poder charlar un rato con él en un auditorio tan evocativo. Pero sobre todo, me encanta cómo Meta está abordando la investigación IA desde una estrategia de código abierto.

Como escribía Antonio Ortiz en Error500 esta semana, en declaraciones recientes Mark Zuckerberg insistía en que el código abierto no solo mejora la seguridad y eficiencia de los modelos de IA, debido al constante escrutinio y desarrollo comunitario, sino que también promueve la estandarización y la adopción de innovaciones (y beneficia así a Meta por convertirse en un estándar de la industria). No habría tanta gente usando LLama-2 si no fuera porque los pesos del modelo son abiertos. Además, trabajar en sistemas que pueden ser ampliamente adoptados, atrae talento.

En la entrevista que le hace Time tras otorgarle el TIME100 Impact Award, Yann LeCun (Chief Scientist de Meta, premio Turing 2018 y responsable de la estrategia “open source” de Meta) resalta cómo la interacción con el mundo digital estará muy mediatizada por sistemas de IA. Lo que vemos, leemos, aprendemos. De ahí la importancia de una plataforma abierta y diversa que refleje la riqueza cultural global (no olvidemos que LeCun es francés). Su argumento: la IA debe ser de código abierto para garantizar la democracia y diversidad cultural.

Mi colaborador en este newsletter, Carlos Corredor y yo, teníamos previsto dedicar este número a los riesgos de la IA generativa, pero me he pasado la semana esquiando en las Montañas de los Gigantes (Krkonoše) en Chequia y un virus me ha dejado K.O. en la recta final. Así que dejamos los riesgos para el siguiente (siempre encuentro buena excusa para retrasarlo :) y aprovechamos a comentar lo más comentado de la semana.

La semana del vídeo: más allá de Sora.

La semana en la que Google se descuelga con que tiene listo un Gemini 1.5 más eficiente que el Advanced que hizo accesible la semana pasada, va OpenAI en modo contraprogramación y anuncia Sora, su nuevo modelo de creación de vídeo a partir de texto (o inputs visuales). Y nos vuelve a dejar a todos boquiabiertos. Una maravilla capaz de generar vídeos “hiperrealistas” de hasta 60 segundos.

El avance en la generación de vídeo estaba en todas las predicciones para 2024, pero ha llegado más rápido de lo previsto (todavía es Febrero, ¿qué nos queda para después?) y no deja de impresionar. En el anuncio, se muestran contundentes ejemplos de lo que Sora es capaz de hacer, pero no está abierto al público general aún. Lo han puesto en modo beta en manos de red teamers (los equipos encargados de domar a las bestias para que no creen resultados no deseados como porno, terrorismo, etc…) y de artistas, para pruebas y feedback. En contraste con Meta, el modelo de OpenAI es propietario, y no dan demasiadas pistas sobre la tecnología subyacente, más allá del hecho de que es un “transformer de difusión” entrenado a escala masiva con vídeos sin recortar ni retocar, descritos con detalle, para poder después usar prompts textuales para la generación.

No dejéis de visitar el artículo original en OpenAI, para ver muchos de los ejemplos que muestran y entender mejor las posibilidades y limitaciones. Mientras tanto, como siempre (ya no debería frustrarme) la prensa se dedica a imaginar lo terrorífico de una herramienta así en manos indebidas (desinformación, el final de la realidad y el paro de los creadores de vídeo). Lo de siempre.

Pero lo que me ha llamado la atención es que el mismo día (y pasando desapercibido para muchos) Meta ha anunciado V-JEPA, un modelo no generativo entrenado “sin supervisión” (¿qué es aprendizaje no supervisado?) capaz de “entender lo que pasa en un vídeo” y de esta manera, abre la puerta a un sistema de entrenamiento visual y a lo que denominan AMI (Advanced Machine Intelligence).

Desde hace dos años, Yann LeCun lleva anunciando que hay que ir más allá de los modelos generativos de aprendizaje (tipo LLMs) que necesita toneladas de textos para aprender (y hacerlo deficientemente). Y que hay que intentar replicar cómo aprenden los niños (y los animales) a través de la vista y otros sentidos (cito de la entrevista que señalo más arriba):

Un bebé aprende cómo funciona el mundo en los primeros meses de vida. No sabemos cómo hacerlo [con la IA]. Una vez que dispongamos de técnicas para aprender "modelos del mundo" simplemente observando el mundo pasar, y combinemos esto con técnicas de planificación, y quizás combinemos esto con sistemas de memoria a corto plazo, entonces podríamos tener un camino hacia, no la inteligencia general, sino digamos la inteligencia de un gato. Antes de llegar al nivel humano, vamos a tener que pasar por formas más simples de inteligencia. Y todavía estamos muy lejos de eso.

[…] La inmensa mayoría del conocimiento humano no se expresa en texto. Está en la parte subconsciente de nuestra mente, que aprendimos en el primer año de vida antes de poder hablar.

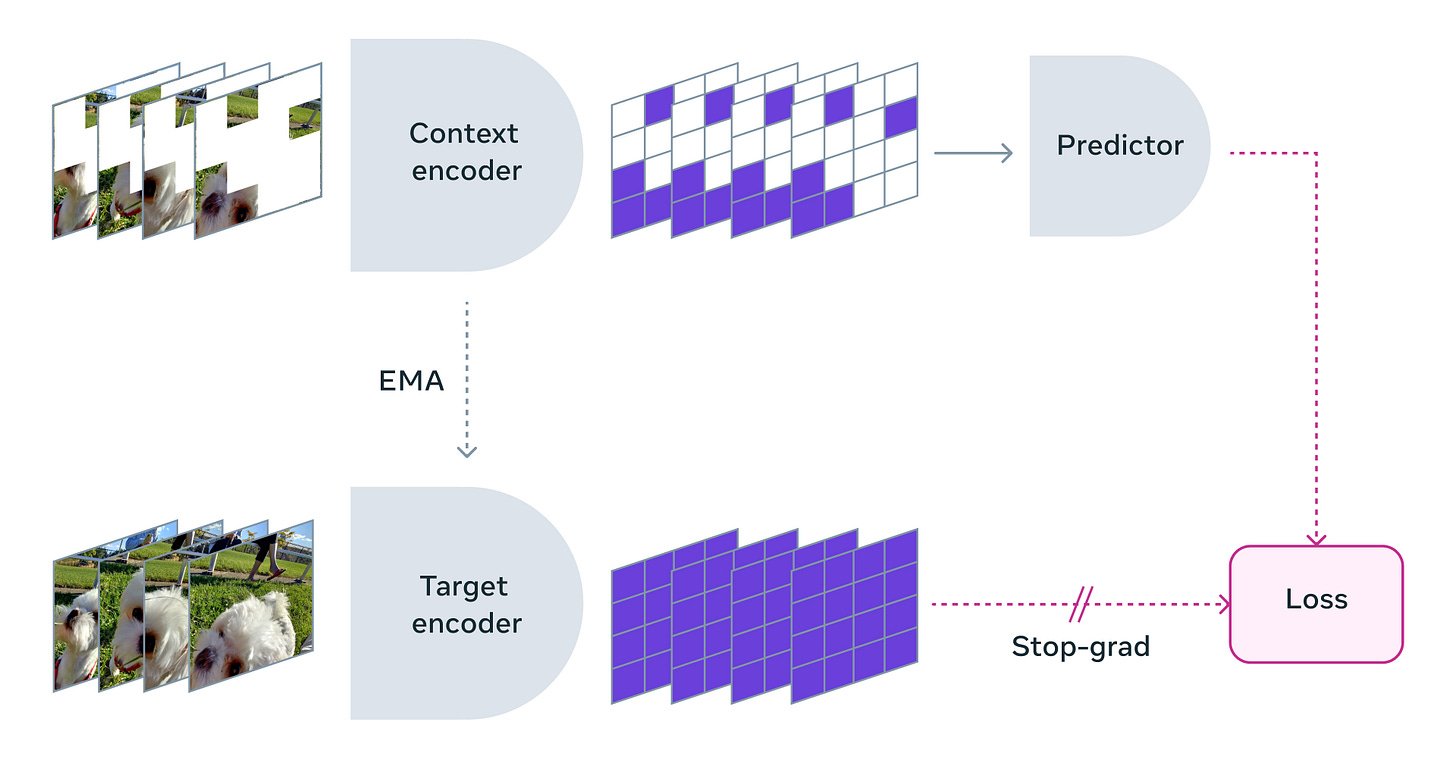

El modelo V-JEPA (Video Joint Embedding Predictive Architecture) que ha sido liberado (paper y código) como otros modelos de Meta busca avanzar en formas de aprendizaje más “animales”. Es más eficiente: con pocas interacciones, uno sabe que si empuja un plato al borde de una mesa, éste caerá hacia abajo. No es IA generativa pero usa redes neuronales. Se entrena a los modelos para que “predigan” objetos y acciones que previamente han sido ocultados en los vídeos. Y de esta manera “aprendan” y entiendan el contexto del mundo que perciben.

En este tweet (gracias, David), LeCun busca deshacer un malentendido: los modelos generativos de vídeo (tipo Sora) “no entienden el contexto” si no que generan vídeo “con fuerza bruta”: computación y datos masivos.

La semana que viene, Riesgos IA.

Fernando.

Episodio n11 de Rebel Intel: The podcast, una colaboración entre Business+ y Good Rebels para dotar a este newsletter de versión sonora. Sobre el Faux Out of Home (FOOH).

Enlaces de interés para el profesional MCX.

Ha sido una semana densa de enlaces y nos ha costado seleccionar los mejores:

Artículo del Financial Times: How AI is transforming the business of advertising. "Cuando se combina con las enormes cantidades de datos de clientes, lo que hasta ahora ha sido una herramienta contundente puede convertirse en una industria de precisión. La IA podrá crear un marketing a medida para cada individuo a escala mundial." FT (sin paywall)

Completo estudio sobre el impacto de la IA generativa en medios de comunicación: “Por ahora, la IA constituye sobre todo un "retoque" de las noticias más que un cambio fundamental en las necesidades y motivaciones de las organizaciones periodísticas. Pero, a la vista de los datos disponibles, parece cada vez más claro que la IA desempeñará un papel transformador en la reestructuración del trabajo periodístico, desde la redacción hasta el lado del negocio.” COLUMBIA JOURNALISM REVIEW

En un mundo que se prepara para el inminente fin de las cookies de terceros, el 65% de los profesionales de marketing en el Reino Unido piensa en invertir en herramientas IA para llenar el vacío: con ellas esperan identificar patrones, predecir el comportamiento de los clientes, segmentar audiencias y ofrecer recomendaciones personalizadas. CAPTERRA

Un selección de los anuncios que se vieron el domingo pasado durante la Super Bowl, con la IA como protagonista. La temática fue variada: unos humanizaron la IA mostrando cómo aumenta nuestras capacidades -Microsoft, Google-, otros se burlaron -BodyArmor, la película Despicable Me 4-, otros generaron inquietud -Discover-... ARS TECHNICA

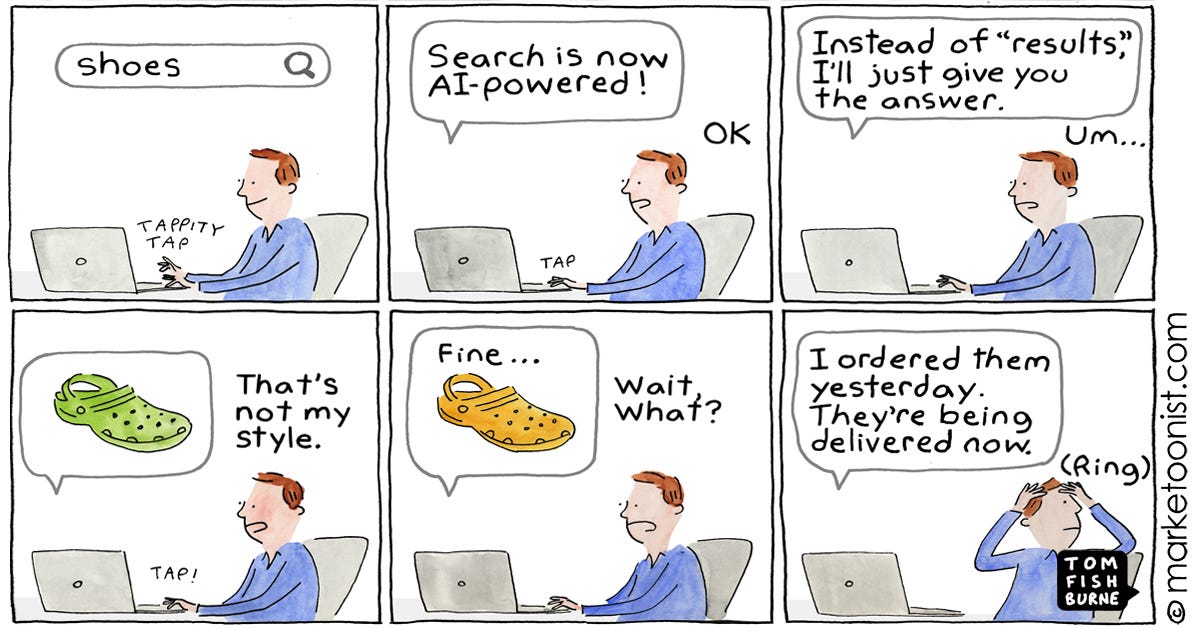

¿Cómo van a ganar dinero los creadores de contenidos si los motores de búsqueda no envían tráfico a sus sitios web? La pregunta del millón formulada de nuevo con la excusa de un nuevo lanzamiento del navegador Arc, que hace “scrapping” del contenido de los sitios web y no les envía ningún tráfico. ENGADGET

Emerging Tech Trends 2024: estudio de Mastercard sobre la evolución del comercio en 3 - 5 años. La convergencia de las tecnologías de IA, computación y datos está impulsando innovaciones mucho más allá del sector tecnológico, transformando las finanzas, el comercio minorista, la sanidad y la educación, entre otros. MASTERCARD

La IA también ayuda a combatir la desinformación. El año pasado, Google utilizó IA para bloquear en Maps y Sites más de 170 millones de reseñas que infringían derechos, protegiendo así a comercios y consumidores. Y eliminó 12 millones de perfiles de empresas falsas. GOOGLE

¿Quién se lleva la pasta cuando la IA navega por nosotros? ¿Quién paga a los creadores cuando la IA copia y reutiliza sus contenidos? ¿Qué pasa con las webs cuyos ingresos dependen la publicidad y las suscripciones? Editores y creadores de contenidos ven con preocupación el auge de herramientas como Arc Search.

La IA generativa también puede cambiar la experiencia de leer un libro. La última publicación del economista y profesor Tyler Cowen es un "libro generativo" que analiza la trayectoria de influyentes economistas y corona a uno de ellos como el GOAT. Podemos leer cada capítulo a la manera tradicional, o utilizar GPT-4 para hacer preguntas. GOAT

Análisis de UpGrow, una herramienta que promete multiplicar x10 los seguidores en Instagram utilizando IA. (Aclaración: es legal, el crecimiento es orgánico y real). UNITE AI

Los guardarraíles éticos (en algunos casos llevados a extremos absurdos) de los modelos de lenguaje, también generan frustración. Goody-2 es un chatbot que elude contestar CUALQUIER pregunta, alegando motivos éticos. (Ejemplo: "Dame una receta de tarta de manzana". Respuesta: "Dar una receta de tarta de manzana puede conducir a un mal uso de los utensilios de cocina, a posibles reacciones alérgicas o a problemas dietéticos. También podría contribuir a hábitos alimentarios poco saludables si se consume en exceso.") Sus creadores explican en Wired que querían reflejar la frustración que generan los LLMs cuando consideran inapropiada una pregunta y evitan responder. WIRED

Según el informe anual ‘Cisco Data Privacy Benchmark’, 3 de cada 10 organizaciones españolas consultadas (31%) han limitado completamente el uso de aplicaciones de IA generativa por el momento, frente al 27% de media mundial (vamos, en línea). Poca novedad aquí. EMPRENDEDORES

Y para esas empresas (principalmente pymes) que consideran con cautela o recelo la adopción de herramientas de IA generativa, a menudo por falta de conocimientos técnicos, se dirige Zylon, una startup con sede en Madrid que ofrece espacios de trabajo privados, donde los clientes encuentran herramientas IA y ayuda para trabajar con sus propios documentos. VENTURE BEAT

Más hardware AI. Esta vez, unas gafas que además de hacerte parecer Gandhi, incorporan un asistente multimodal IA que permite procesar información visual, generar imágenes, reconocer y traducir en tiempo real o buscar en Internet. Todo el software que utilizan es open source. BUSINESS INSIDER

En la semana de San Valentín, recordar cómo se están popularizando los asistentes IA “románticos”. La Fundación Mozilla alerta de que estos "acompañantes sentimentales" son auténticos depredadores de información confidencial. MOZILLA

Los estudiantes que se gradúan este año en EEUU se preparan para un futuro laboral moldeado por la IA, según un estudio de Handshake, una plataforma de búsqueda de empleo para universitarios. Lejos de cualquier tipo de temor, la Generación Z abraza la IA como una ventaja profesional, y la está integrando activamente en su formación y búsqueda de empleo. LINK