Por qué la transparencia de los modelos IA ayuda a desarrollar una IA segura.

Algunos famosos fatalistas IA se han reunido en Londres para saludar al público y hacer parecer listo a Rishi Sunak (con dudoso éxito).

En la semana de la cumbre sobre seguridad IA, Meta y Demócrata organizaban en Madrid un desayuno de trabajo con Carlos Romero y Markus Reinisch. El primero es el responsable de transformación digital de la representación permanente española en Europa, y participa en el comité que asesora al Parlamento Europeo en la elaboración de la ley IA de la UE. El segundo, VP de Asuntos Públicos en Europa de Meta. Yo acudía en calidad de presidente del Foro IA. El lunes se publicarán las conclusiones. Por mi parte, creo que la intervención que cambió el paso fue la de David Llorente de Narrativa, que señaló que de regular habría que hacerlo para que el próximo OpenAI fuera europeo, y no poner trabas y evitar que se creen empresas de referencia de IA europeas.

Cumbre sobre el desarrollo seguro de la IA.

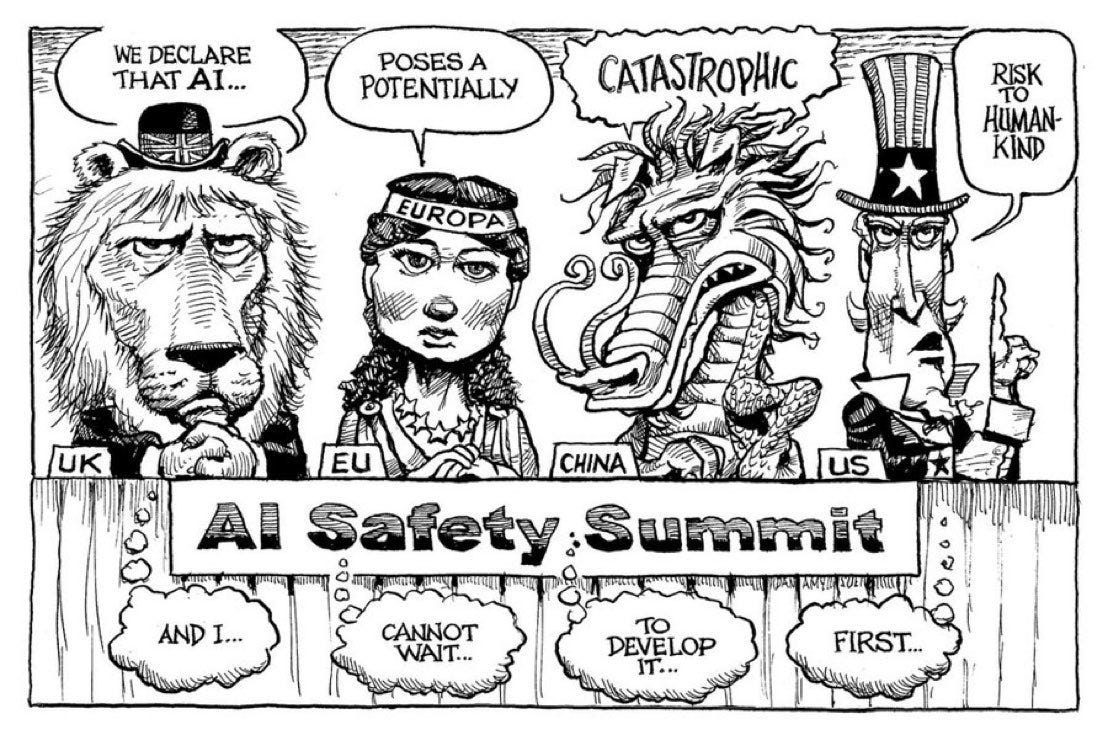

En la primera edición de la AI Safety Summit, líderes tecnológicos, políticos y académicos debatieron en Londres sobre oportunidades y riesgos asociados a la IA. Varios países firmaron la declaración de Bletchley Park para el desarrollo seguro y responsable. Pero lo cierto es que con EE.UU. regulando por su cuenta, la UE a punto de definir su propio marco jurídico, China en su propio contexto y Rusia defendiendo la no regulación, no deberíamos engañarnos: este ha sido un evento más simbólico que vinculante. Primer párrafo de la declaración:

La Inteligencia Artificial (IA) presenta enormes oportunidades globales: tiene el potencial de transformar y mejorar el bienestar humano, la paz y la prosperidad. Para lograrlo, afirmamos que, por el bien de todos, la IA debe diseñarse, desarrollarse, desplegarse y utilizarse de forma segura, centrada en el ser humano, fiable y responsable. Acogemos con satisfacción los esfuerzos realizados hasta ahora por la comunidad internacional para cooperar en materia de IA con el fin de promover el crecimiento económico integrador, el desarrollo sostenible y la innovación, proteger los derechos humanos y las libertades fundamentales, y fomentar la confianza pública en los sistemas de IA para que desarrollen plenamente su potencial.

Como se comenta en The Guardian, la idea de que la inteligencia artificial presenta un riesgo existencial para la humanidad es algo que sigue dividiendo la opinión de científicos y no parece que la cumbre haya cambiado nada sobre esto. El pasado lunes, uno de los padrinos de las redes neuronales y director científico IA de Meta, Yann LeCun acusaba duramente en X a algunas cabezas muy visibles de meter miedo para generar regulación que beneficie a las grandes corporaciones:

He argumentado muchas veces que los escenarios catastrofistas que teméis son absurdos. No voy a repetirlos aquí. Pero la cuestión principal es que si los sistemas de IA potentes se guían por objetivos (que incluyen “guardrails”), serán seguros y controlables porque *nosotros* fijamos esas barreras y objetivos.

Junto a Andrew Ng (otro padrino, la criatura tiene varios) se han convertido en las figuras más relevantes frente a Geoffrey Hinton o Yoshua Bengio (padrinos ambos también) que sí han decidido optar por avisarnos del lobo que podría venir.

La Orden Ejecutiva del gobierno americano.

Esta misma semana, Joe Biden ha publicado una Orden Ejecutiva que establece “nuevas normas de seguridad y protección de la IA, protege la intimidad de los estadounidenses, fomenta la equidad y los derechos civiles, defiende a los consumidores y a los trabajadores, promueve la innovación y la competencia, impulsa el liderazgo estadounidense en el mundo, etc”. Destaco las normas de seguridad IA:

Exigir que los desarrolladores de los sistemas de IA más potentes compartan los resultados de sus pruebas de seguridad y otra información crítica con el gobierno de EE.UU.

Desarrollar normas, herramientas y pruebas que ayuden a garantizar que los sistemas de IA son seguros y fiables.

Proteger contra los riesgos de utilizar la IA para diseñar materiales biológicos peligrosos.

Proteger a los estadounidenses del fraude y el engaño posibilitados por la IA estableciendo normas y mejores prácticas para detectar contenidos generados por la IA y autenticar contenidos oficiales.

Establecer un programa avanzado de ciberseguridad para desarrollar herramientas de IA que permitan detectar y corregir vulnerabilidades en software crítico.

Ordenar el desarrollo de un Memorándum de Seguridad Nacional que dirija nuevas acciones sobre IA y seguridad.

Algunos piensan que esta Orden Ejecutiva es un conjunto de aportaciones políticas de muchas partes interesadas y que sin ser ley, parece sobre todo querer poner puertas a la IA sin consenso científico (como sí ocurre con el cambio climático) y que terminará estrangulando el desarrollo de la inteligencia artificial. En palabras de Steven Sinofsky “es mucho menos un documento sobre lo que debería hacerse con el potencial de la tecnología que uno que busca los límites de lo que puede hacerse legalmente para frenar la innovación”. Tim O’Reilly tiene una visión más positiva sobre OE, aunque piensa que se centra más en unos hipotéticos riesgos existenciales futuros que en los problemas que experimentamos ya hoy (una postura cercana a LeCun).

Transparencia y apertura de los modelos: antídoto, no veneno.

Stanford’s Center for Research on Foundation Models (CRFM) ha creado el Foundation Model Transparency Index, que puntúa a los creadores de modelos según 100 indicadores. Puedes leer el paper completo, o ir a directo a los resultados. “El modelo mejor puntuado obtiene sólo 54 puntos sobre 100. Ninguno está cerca de ofrecer una transparencia adecuada, lo que revela una falta de transparencia fundamental en la industria de la IA.”

Hace un mes, Github, Creative Commons y otras organizaciones elaboraron un documento explicando cómo la defensa de estos modelos abiertos debería quedar reflejada en la ley europea que se avecina. Y esta semana se ha hecho otra declaración coordinada por Mozilla y firmada por cientos de profesionales y científicos (Andrew Ng, LeCun y O’Reilly entre muchos otros), para defender la apertura de modelos fundacionales. Yo también he firmado:

Los modelos abiertos conllevan riesgos y vulnerabilidades: actores malintencionados pueden abusar de ellos o ser desplegados por desarrolladores ineptos. Sin embargo, hemos muchas veces que lo mismo ocurre con las tecnologías patentadas, y que aumentar el acceso público y el escrutinio hace que la tecnología sea más segura, no más peligrosa. […]

La historia demuestra que precipitarse hacia el tipo equivocado de regulación puede conducir a concentraciones de poder que perjudiquen la competencia y la innovación. Los modelos abiertos pueden informar un debate público y mejorar la elaboración de políticas. Si nuestros objetivos son la seguridad y la rendición de cuentas, la apertura y la transparencia son ingredientes esenciales para alcanzarlos.

¿Puede la regulación matar la innovación?

Con la Orden Ejecutiva de Biden, como con la anticipada ley IA de la UE, el problema es que estamos en una fase demasiado incipiente para legislar sobre algo tan general como la IA. Pero al mismo tiempo, no queremos que un exceso de laissez-faire haga que el desarrollo se escape fuera del control humano. La IA tiene demasiadas aristas y evoluciona demasiado rápido. Nos estamos centrando en los riesgos, pero cuesta poner foco en el desarrollo de los beneficios (muchos).

Le decía a Carlos Romero en el desayuno de Meta que me alegraba de no estar en su piel. Prefiero ir a dar mi punto de vista, que verme con la responsabilidad de forzar una legislación en los próximos dos meses (en parte porque acaba la presidencia española) cuando aún no estamos preparados para anticipar lo que viene. No tiene por qué ser permanente o definitiva, pero la regulación que llegue tendrá un impacto en el desarrollo tecnológico, la innovación y el desarrollo de startups y en el progreso social de los próximos años. Buena suerte a todos.

El próximo domingo, vuelvo a tu buzón.

Fernando.

La semana que viene lanzamos Rebel Intel: The podcast, una colaboración entre Business+ y Good Rebels para dotar a este newsletter de versión sonora. Cada semana, Isabel Benítez y servidor haremos lo posible para olvidar que una cámara convierte el podcast en videopodcast. Disponible en sus plataformas favoritas de podcast, en Business+ y en YouTube.

Enlaces de interés para el profesional MCX.

Esta semana, mi amigo y colaborador Carlos Corredor ha sido de gran ayuda ayudándome a seleccionar varios enlaces relevantes. Cada vez hay más, y junto al grano, también crece la paja:

Meta, Google, TikTok, Amazon están poniendo a disposición de los anunciantes herramientas de IA para generar los anuncios y mejorar las fotografías. Para el anunciante, supone un ahorro de costes (sesiones de shooting, creatividad, etc) y ayuda a hacer más atractivas las imágenes. Lo que ocurre es que rápidamente se llenará todo de imágenes algo “impostadas”. ¿Buscará el comprador contexto en otros sitios online en búsqueda de la “autenticidad perdida”? ¿Irá a leer reseñas, mirar fotos reales de otros compradores, buscando otras webs con referencias…? ¿O nos acostumbraremos y seguiremos la ley del mínimo esfuerzo? NYMAG

Un ejemplo de uso de la IA conversacional en la investigación de mercado: Avery es un bot que se adapta a las características demográficas de los clientes para hacerles sugerencias personalizadas. Ha sido entrenado a partir de los hábitos de compra de 1.000 usuarios de la Generación Z. BUSINESS INSIDER

7 casos de uso de la IA generativa aplicada a mejorar la experiencia de cliente: desde asistentes de voz contextuales, IA que analiza y mejora el customer journey hasta respuestas de FAQs personalizadas. CXNETWORK

Por cada dólar que las empresas invierten en IA, obtienen un rendimiento medio de 3,5 dólares, y un 5% de las organizaciones obtienen un rendimiento medio de 8 dólares. El 92% de las implantaciones de IA están tardando 12 meses o menos. Infografía del estudio de IDC sobre el valor empresarial de la IA (ojo, está patrocinada por Microsoft :) IDC

Frente a la tormenta que se avecina, un magnífico informe sobre el marco regulatorio y consideraciones a tener en cuenta. El panorama regulatorio global de la IA, según EY

Genie, desarrollado por Luna, es una aplicación que genera diseños en 3D a partir de texto. Escribes un prompt y Genie genera cuatro modelos 3D diferentes, que se pueden descargar en formato GLB. Permite detallar los materiales, texturas y estilos de los modelos, y verlos en realidad aumentada. Está disponible gratis en Discord. ¿Un game changer para industrias como los videojuegos? THE DECODER

Los nativos digitales parecen unos buenos aliados para la IA. El 88% de los jóvenes (Gen Z) considera que la IA mejorará la experiencia de compra, gracias a funcionalidades como las comparativas de precios (47%), la búsqueda de ofertas (45%), la recepción de ofertas relevantes y sugerencias de productos (41%), la asistencia personalizada (37%) y la búsqueda de opiniones (28%). RETAIL CX

El uso de herramientas IA en la “creator economy”. Cómo suben y bajan de popularidad las herramientas, como Midjourney permite ahora mezclar dos imágenes, datos de uso y mucho, mucho más en un largo e interesante artículo de Rex Woodbury. PIXEL PERFECT

Cómo la IA le ha cambiado el paso al marketing en 2023: “Los días de las campañas creativas de marketing y publicidad al estilo de Mad Men han quedado atrás. Tras años de lo que los consultores llevan tiempo llamando "transformación digital", el marketing "ha pasado de ser un campo principalmente creativo a otro profundamente basado en los datos", especialmente para quienes venden a empresas, afirma Kelsey Havens, responsable de marketing de Upbound.” VENTURE BEAT

LinkedIn incorpora funcionalidades IA: leen el feed del usuario y crean resúmenes personalizados; también detectan qué contactos están hablando de determinado tema, y prestan asistencia para redactar, tanto contenidos como propuestas de candidatos buscando empleo. De momento, solo para usuarios premium. FAST COMPANY

Apple no ha dejado nunca de trabajar en IA (y en IA generativa), pero parece que todo este frenesí del 2023 le haya pillado un poco fuera de juego. Pero a su ritmo, y sin darnos cuenta, ya tenemos en el mercado los nuevos chips M3 optimizados para el uso de IA generativa en los mac y progresivamente, se van conociendo detalles de cómo la IA irá permeando progresivamente en el software de Apple y de los desarrolladores para sus sistemas operativos. BLOOMBERG, CHIPS

Chat GPT lidera las descargas de apps IA en dispositivos móviles: 23 millones en septiembre, y 38,8 millones de usuarios activos. Sin embargo, no es la app que más ingresos genera; estas son Chat & Ask AI y ChatOn. TECHCRUNCH

Ojito con los detectores de contenido creado por IA. AUTHORY