Un ChatGPT de bolsillo.

Microsoft ha presentado Phi-3 Mini. Un modelo pequeño de lenguaje que puede ser ejecutado en un dispositivo personal.

Si estás en Madrid este martes a las 18.00h y quieres venir a la presentación del Foro IA, puedes inscribirte aquí. Destaca la mesa redonda moderada por Chema Palomares, VP del Foro IA y en la que participan David Carro, Director Head of Digital & Agile Transformation en Vodafone, Arantxa Gulias, Head of Digital Communications en Ferrovial, Jorge Álvarez-Naveiro, Head of Brand, Comms and Alliances en Antolín y Carmen Queipo de Llano, Directora Académica del Programa en Dirección de Comunicación y Management en IE Business School.

Que los grandes modelos de lenguaje (LLMs) dejen de ser grandes, y puedan ser ejecutados en un dispositivo personal (como un teléfono), implica que no hace falta estar conectado a Internet para utilizarles. Y no hay que enviar datos a un sistema en la nube con enorme capacidad de computación. Si queremos mantener conversaciones privadas con un psicólogo (o una pareja) creado por IA, es más fácil que no se produzcan fugas si el modelo está en el teléfono y las conversaciones se encuentran protegidas por nuestro acceso biométrico.

Esta fue la apuesta por la privacidad de Apple (de la que presume en sus anuncios). En un iPhone, la detección y clasificación de personas por reconocimiento facial en la app Photos se realizan en el dispositivo de manera local e independiente de tu Mac o tu iPad (en la nube no hay sincronización de los datos personales, sí de las fotos). En principio, parecía que podría perjudicarles este enfoque ya que los LLMs requieren actualmente de una capacidad computacional enorme. Pero en los últimos meses, la investigación avanza en el desarrollo de modelos pequeños (SLMs). Por un lado, se investiga con arquitecturas especializadas en funciones específicas (resumir un texto, escribir un mensaje, transcribir un mensaje de voz, navegar por una pantalla) que son más eficientes. Pero la semana pasada, Microsoft anunció su Phi-3 Mini y Apple su OpenELM. Ambos son modelos pequeños que se acercan a las capacidades de los grandes. Hoy analizamos en detalle el Phi-3 Mini, que presume de tener una capacidad similar a la de GPT 3.5 (el modelo usado en ChatGPT en su versión gratuita).

Estos SLMs allanarían el camino para introducir interfaces de conversacionales con voz que funcionan (de verdad, no como Siri o Alexa) prácticamente en todos los dispositivos electrónicos y electrodomésticos, lo cual supondrá una aúténtica revolución en la interacción hombre-máquina. Hablarle a una cafetera doméstica y pedirle el flat white como a nosotros nos gusta, sin apretar botones (aunque varios botones se mantengan para uso rápido). Configurar el tiempo que sonará la alarma de finalización de un horno microondas sin tener que leerse el manual de instrucciones en cada corte eléctrico. O que una nevera te diga que llames a un técnico, y pueda explicar cuál es el problema más allá de un código numérico. Son casos de uso para los que cada vez queda menos.

Carlos Corredor, analista de Good Rebels investiga y profundiza esta semana sobre el Phi-3 Mini, el modelo anunciado por Microsoft la semana pasada, y las potenciales aplicaciones de estos modelos pequeños de lenguaje.

Phi-3 Mini: una bestia en tu smartphone.

Carlos Corredor, Good Rebels.

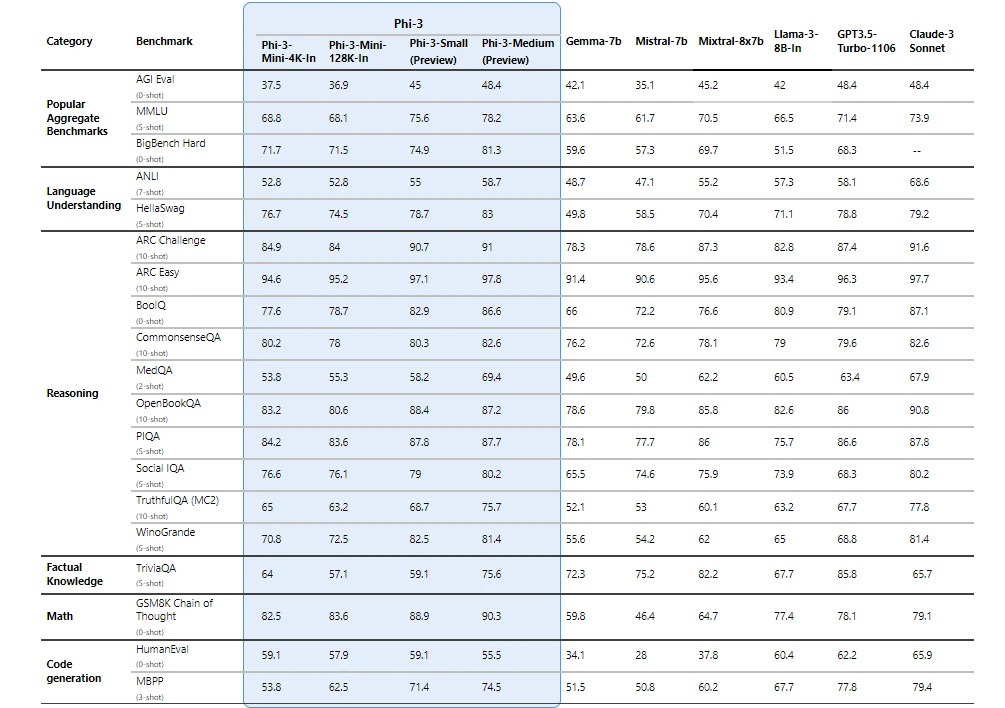

La semana pasada Microsoft anunció el lanzamiento de Phi-3 Mini. Un SLM (Small Language Model), punta de lanza de una revolución en la experiencia de usuario y en dispositivos móviles: una IA de bolsillo. No es el primer modelo pequeño que se hace público (Mistral, Apple, Google, … todos están avanzando en este terreno), pero es el que tiene mejor rendimiento hasta la fecha. Phi-3 es la continuación de Phi-1, presentado en junio de 2023, y Phi-2, del pasado diciembre. Mini es el primero de la familia, porque Microsoft ha anunciado otras dos versiones (Small y Medium) que verán la luz más adelante, y que serán significativamente más potentes.

Técnicamente, Phi-3 Mini es un modelo transformer que admite hasta 4.000 tokens de contexto (la versión extendida Phi-3 Mini-128K amplía hasta 128.000 tokens). Phi-3 Mini contiene 3.800 millones de parámetros (los modelos venideros tendrán 7.000 millones y 14.000 millones) y se ha entrenado con 3.300 millones de tokens. Por situar estos números, PaLM 2 de Google contiene cientos de miles de millones de parámetros, y GPT-4 podría tener más de un billón.

La robustez y ligereza de Phi-3 Mini le permite ejecutarse en un dispositivo móvil de manera más que solvente. Sólo necesita 8 GBs de RAM para funcionar, y puede procesar tokens a una velocidad razonable con una CPU estándar. Phi-3 demanda muchos menos recursos que los grandes modelos de lenguaje. Por eso, es capaz de ofrecer resultados que no envidian en tanto a los LLMs, con la salvedad de hacerlo dentro de un dispositivo con prestaciones limitadas. Phi-3 Mini promete ofrecer en un smartphone un rendimiento similar al de ChatGPT 3.5 o Mixtral 8x7B, incluso sin conexión a internet.

Un entrenamiento más eficiente (y barato).

El hito que hace posible este salto lo encontramos en la metodología del entrenamiento de Phi-3. Microsoft ha utilizado un sistema de curación de datos de alta precisión (algo parecido a lo que ofrece la startup Datalogy.ai). En una primera fase, el modelo se expuso a diferentes fuentes para dotarle de conocimiento general. Después, se combinaron datos filtrados con datos sintéticos (creados por LLMs) para adquirir razonamiento lógico y conocimientos específicos. Un proceso que Microsoft ha bautizado como “régimen óptimo de datos”, en oposición a los entrenamientos basados en potencia de cálculo y datos masivos. El objetivo es calibrar los datos de entrenamiento para que se ajusten a la escala del modelo, proporcionando el nivel adecuado de conocimientos y capacidad de razonamiento, y dejando al mismo tiempo espacio para otras funciones.

Entrenar los modelos punteros (GPT-4, GPT-5, Gemini Ultra, Claude 3, etc) cuesta millones de dólares. Y cada vez que solicitamos a la IA una acción (“Crea una imagen de…”, “Traduce este texto”, etc) hay unos costes implícitos, que acaba sumando enormes gastos para la empresa que recibe las peticiones. Un SML que funciona dentro de un dispositivo móvil sin necesidad de conectarse a la nube elimina muchos de estos costes, reduciendo drásticamente el impacto medioambiental de la IA.

Hacia una nueva experiencia de usuario

Los SMLs no reemplazarán a los LLMs, sino que buscarán complementarlos. Al funcionar en dispositivos personales, abren la puerta a multitud de aplicaciones y servicios en los que tienen importancia el tamaño y el contexto. Como apuntaba Sonali Yadav, Product Manager for Generative AI de Microsoft:

Lo que vamos a empezar a ver no es un cambio de grande a pequeño, sino un cambio de una categoría única de modelos a un portfolio de soluciones para cada necesidad.

Los SMLs podrán estar en multitud de dispositivos: en un coche, en un PC sin conexión, en sensores de fábricas, en cámaras, en estaciones medioambientales… Los datos se guardan dentro del dispositivo, lo que aumenta la seguridad y disminuye la latencia. Las aplicaciones son infinitas. Un granjero que observa signos de enfermedad en un cultivo podría usar un dispositivo multimodal con SML instalado y averiguar cómo combatir la plaga, incluso si se encuentra en una zona remota sin cobertura.

Pensemos en las posibilidades de la IA conversacional dentro del dispositivo móvil. Al ejecutarse en modo local, un asistente inteligente puede ofrecer respuestas inmediatas a cualquier pregunta o problema: aquí se abren usos para asistencia sanitaria, para educación, para programación de software, etc.

Tal vez prescindamos de los buscadores, porque Microsoft ya ha anunciado que trabaja en la integración de datos en tiempo real. Tal vez nos acompañará un personal shopper en cada teléfono. O un asesor financiero. O un terapeuta. O un nutricionista. O un… estos modelos prometen desencadenar una nueva ola de innovación, haciendo que la IA sea más accesible para todos y se encuentre mejor integrada en nuestro día a día.

El próximo domingo, volvemos a tu buzón.

Fernando.

Enlaces de interés para el profesional MCX.

Lecturas seleccionadas de la semana:

La IA en la empresa no es solo una: es un ecosistema diverso y complejo, con diferentes tipos de modelos (pequeños, medios, grandes) que responden a necesidades específicas. El ecosistema IA se forma a partir de un delicado equilibrio entre perspicacia técnica y gestión estratégica, garantizando que cada modelo funcione de forma eficaz y ética dentro del marco corporativo. LINK

Muchos datos sobre la percepción y el uso de la IA en el estudio What's next with AI, de The Verge y Vox Media. Por ejemplo: el 61% de los GenZ y el 53% de los millennials utilizan la IA en lugar de Google para investigar temas. La adopción de la IA se va ralentizando, pero surge una categoría de súper usuarios. Redactar emails es el uso que más ha crecido para la IA. Y el 55% de los consumidores confía en la exactitud de la información generada por IA. THE VERGE

Otro caso de estudio sobre cómo una empresa se reinventa con la IA. Lo cuenta Dustin Moskovitz, co fundador y CEO de Asana. Pidieron a todos los empleados que identificaran casos de uso de la IA, y aunque muchos se mostraban escépticos, pronto "comenzaron a florecer en cada rincón de la compañía": RRHH, marketing, Ventas, CX, programadores... Todos los equipos aumentaron su rendimiento y pudieron prescindir de las tareas de menor valor añadido. ASANA

“La IA podría acabar con la mayoría de los call centers”, dice el responsable de Tata Consultancy Services, aunque advierte que aún es pronto (calcula en un año). Como buena consultora IT, va en su negocio hacer proclamas como esta a los cuatro vientos. TCS, con 600.000 empleados, presume de facturación record y de que sus ventas de proyectos Gen AI se están duplicando cada trimestre (similar a los datos de otras consultoras). Pero es cierto que las señales de los últimos meses (y sonados casos de uso como el de Klarna) apuntan que los chatbots de atención al cliente estén mejorando a paso veloz con tecnologías como RAG (Retrieval Augmented Generation) y otras mejoras (como Re-Rank de Cohere, o el Safe Reinforced Learning with Human Feedback). FINANCIAL TIMES

Abrir una Coca Cola, escuchar el burbujeo, paladear el sabor por adelantado, tiene mucho de recompensa en el cerebro y algo de fondo musical. Coca Cola ha lanzado Coke Sound Z, una aplicación que permite mezclar y generar combinaciones de sonidos inspiradas en el refresco. THE DRUM

Modelos de moda que posan, pero nunca posaron; focus groups con consumidores que pueden responder a una pregunta sin haberla realmente respondido; y pacientes para ensayos clínicos que no son pacientes de verdad. Todos ellos casos de uso en el ámbito MCX, que tienen un común denominador: “sustituir a los humanos” creando gemelos digitales mediante IA generativa. THE WALL STREET JOURNAL

Microsoft y Estee Lauder unen fuerzas en un laboratorio de innovación IA, que ayudará a la marca de belleza a desarrollar productos, mejorar relaciones con los clientes, aumentar el time to market y ajustar cada producto a los mercados locales. LINK

Building trust in the age of AI, un estudio de Getty Images en el que han preguntado a 30.000 consumidores de 25 países sobre el uso de la IA en campañas de marketing. El 87% considera importante la autenticidad de una imagen, lo que no significa que no se deba emplear la IA en una campaña, sino adoptar un enfoque cauteloso y ser consciente de que algunas empresas (las de salud,servicios financieros o viajes) tienen más que perder que otras. Recordemos que la forma en la que se redacta y elabora una encuesta puede influir en el resultado y aquí la empresa que publica el estudio “necesita” influir en muchas, muchas organizaciones para salvar su modelo de negocio. GETTY IMAGES

Amazon lanza Q Assistant, el equivalente al Copilot de Microsoft. Se presenta en tres modalidades: Q Developer para asistencia en el desarrollo de software; Q Business para l análisis de datos internos, elaboración de informes, etc; y Q Apps, que permite crear aplicaciones dedicadas a partir de lenguaje natural. VENTURE BEAT

El CEO de Ericsson, Borje Ekholm, cree que la regulación de la UE crea un exceso de barreras para la innovación y el desarrollo. Europa corre el peligro de convertirse en un museo: buena comida, magníifica arquitectura, espléndidos escenarios... pero mínima industria. FORTUNE

Humanos compartiendo sus trucos para detectar que un texto ha sido generado por ChatGPT. REDDIT

Indicios de que OpenAI presentará un buscador propio en un evento el próximo 9 de mayo. Cada vez que anunciamos rumores, me da la sensación de que no filtramos el ruido, que es la promesa de esta newsletter. Pero a veces es difícil no sucumbir a la tentación. Que el éxito de Perplexity le está metiendo presión a Google y a OpenAI es evidente. Google, por cierto, ha anunciado una reducción de costes de IA generativa del 80% lo cual son buenas noticias a la hora de no encarecer demasiado la búsqueda llegado el momento de desplegar la SGE a los cuatro vientos. Resumir es algo que un LLM hace bastante bien. Si se le alimenta con uno o varios textos escritos, los condensa y es bastante fiable porque no tiene alucinaciones. Las preguntas: cuál es el modelo de negocio y cuáles son los incentivos de los creadores de contenido (medios, marcas, otros…). LINK

The hardest part es el primer vídeo musical creado con Sora. Lo ha dirigido el cineasta Paul Trillo para Washed Out. No es muy bueno, y se ven las limitaciones de Sora. Pero hace 2 meses esto no era posible … LINK

Fernando, no estaré en Madrid el martes, pero la semana pasada estuve en el IESE en NYC en una sesión conjunta con Vivaldi sobre el impacto de AI en el liderazgo en las empresas y la semana que viene pienso ir a otra sobre el impacto en la estrategia de marca, innovación y marketing. Mucho movimiento (quizá algo de hype) en estos temas. Me interesa también el impacto en el HW: por supuesto Microsoft pasa palabra en este tema, pero Apple seguro que está cocinando algo…