¿Es imparable la comoditización de la inteligencia artificial?

La IA y la ia.

Si quieres saltarte el off-topic inicial y escuchar el artículo de hoy en modo podcast (en español) este es el audio que he creado con NotebookLM.

Arrancamos la edición de hoy con dos off-topics. Primero, un mensaje de apoyo a los familiares de las víctimas y a los afectados por las inundaciones de Valencia. Y mi franca admiración hacia todos los voluntarios y hacia el movimiento ciudadano y empresarial desplegado. No quiero sonar populista y tampoco quiero ser lapidado. Los que estamos en España (saludos a los muchos lectores de otros países) tenemos la suerte de habitar un país europeo del primer mundo, por mucho que algunos tengan interés (o sean negligentes) en hacernos creer lo contrario. Se deben depurar responsabilidades políticas e imaginar cómo articular mejor a futuro la descoordinación entre administración central y administraciones locales. Pero atacar al estado (sea central o local) en general no es la solución. Y pensar que el estado es la solución a todos los males tampoco.

Si una catástrofe como esta hubiera ocurrido en un país con menor desarrollo económico -veréis que me estoy cogiendo las palabras con papel de seda- las consecuencias hubieran sido devastadoras. No dejemos de recordar que somos unos privilegiados. No dejemos de trabajar para mejorar nuestro entorno cercano, sin olvidarnos de que cada semana en África mueren miles de personas (miles de niños incluidos) que no tendrían por qué hacerlo si tuvieran acceso a los recursos que tenemos como país del primer mundo. Y no dejéis de maximizar el retorno de vuestras donaciones a través de Ayuda Efectiva.

El segundo mensaje es de soporte emocional a los votantes americanos que no querían que ganara Trump. Y también a los que sin haber podido votar, no estamos ilusionados con el resultado. Yo quería, como bien explicaba Noah Smith, un mandato presidencial americano que apaciguara los ánimos e intentara desarmar la polarización fomentada por algunos políticos (no todos, demasiados sí). Aunque quizá Smith y un servidor seamos unos ingenuos pensando que esa confrontación continua hubiera mejorado bajo la presidencia demócrata. La polarización es el gran problema que amenaza la democracia y uno de los que más me inquietan si miro a futuro. A mí, un optimista por naturaleza. Si a alguien más le inquieta este tema (o se declara radical de centro como he dicho por aquí alguna vez), la pieza de investigación de publicó hace un par de semanas de The Economist es de esas lecturas que se me quedarán grabadas durante años: Cuando la política va de odiar al otro lado, la democracia sufre (aquí sin paywall). Aunque a lo mejor es preferible no leerlo, porque como apuntaba mi amigo Álvaro Urdiales, las soluciones propuestas no resultan emocionantes.

Y para ir volviendo al asunto que nos concierne, siendo un tecno-optimista racional, tampoco sé si la tecnología o la IA nos ayudará a enderezar la democracia. El inmenso artículo de Dario Amodei (CEO de Anthropic) de hace unas semanas desgranaba una opinión poco halagüeña:

Desgraciadamente, no veo ninguna razón de peso para creer que la IA favorecerá preferente o estructuralmente la democracia y la paz, del mismo modo que creo que favorecerá estructuralmente la salud humana y aliviará la pobreza. Los conflictos humanos son contradictorios y, en principio, la IA puede ayudar tanto a los «buenos» como a los «malos». En todo caso, algunos factores estructurales parecen preocupantes: Parece probable que la IA permita mejorar la propaganda y la vigilancia, dos herramientas fundamentales para los autócratas. Por lo tanto, depende de nosotros como actores individuales inclinar las cosas en la dirección correcta: si queremos que la IA favorezca la democracia y los derechos individuales, vamos a tener que luchar por ese resultado. Mi opinión al respecto es aún más firme que la que tengo sobre la desigualdad internacional: el triunfo de la democracia liberal y la estabilidad política no está garantizado, quizá ni siquiera sea probable, y requerirá un gran sacrificio y compromiso por nuestra parte, como a menudo ha ocurrido en el pasado.

Pero estoy “digresando” que se diría en castellano antiguo. El tema de hoy era hablar de un fenómeno visible y complejo. La IA se nos está comoditizando … ¿o no?

¿Se comoditiza la IA?

Difícil responder a esa pregunta, porque la definición de la palabra es un poco laxa. La comoditización (anglicismo muy usado en español de negocios, pero no aceptado ni recomendado por la RAE) sucede cuando un producto o servicio, que en algún momento se consideró único y/o especializado, se convierte en algo estandarizado (mercantilizado), ampliamente disponible y accesible. Estamos rodeados de commodities que empleamos a diario. En el origen, se trataba de materias primas o fuentes básicas de energía. Ahora el fenómeno alegórico abarca desde los smartphones hasta los servicios de streaming, pasando por el almacenamiento en la nube o el software de gestión empresarial.

Y ahora parece que la IA también se comoditice. Hablamos de la generativa, claro. La otra, la clásica, en la que podríamos englobar el machine learning y el deep learning, la que es capaz de recomendarnos películas o de distinguir objetos en una imagen o reconocer una cara, ya estaba bastante comoditizada de manera similar al software empresarial. Pero hablar de comoditización de productos complejos suele conllevar siempre una simplificación. Y sin embargo, es la percepción que tenemos. Nos hemos acostumbrado a interactuar con naturalidad con unas herramientas extraordinariamente complejas. Y las diferencias entre los modelos fundacionales se van reduciendo.

He usado mucho esta gráfica para ilustrar cómo la IA le ganó la partida a los humanos a la hora de reconocer imágenes. Una vez que superamos la precisión humana del 95% y el rendimiento es casi perfecto, ¿cómo se distingue un algoritmo de otro?

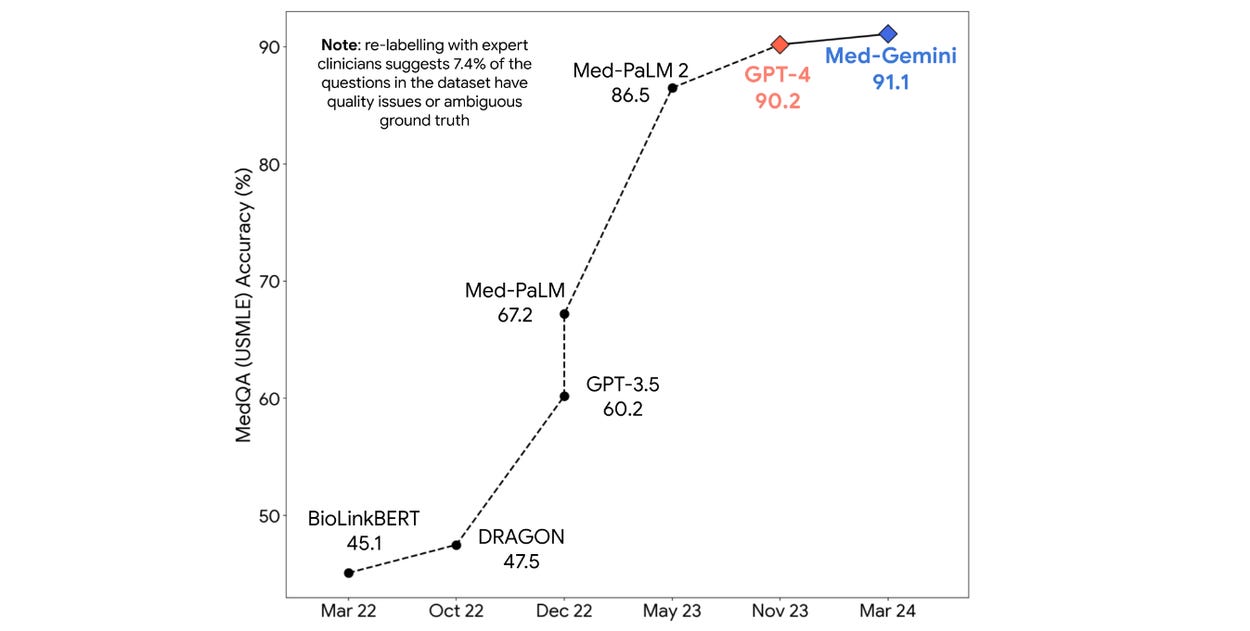

Este otro gráfico ilustra cómo Med Gemini de Google, mejora la calidad de GPT-4 respondiendo las preguntas de un examen médico estándar (MedQA). Pero al mismo tiempo también deja claro que GPT-4, modelo generalista, le ganó por goleada a Med-PaLM, un modelo anterior especializado de Google mediante fine-tuning.

Cuando los modelos alcanzan rendimientos cercanos al 100%, ¿cómo se diferencian unos de otros? Otro ejemplo, la velocidad a la que Midjourney pasó de pintar mal a hacerlo muy bien en apenas 18 meses.

Leaderboards: GPT 4o, primum inter quasi pares.

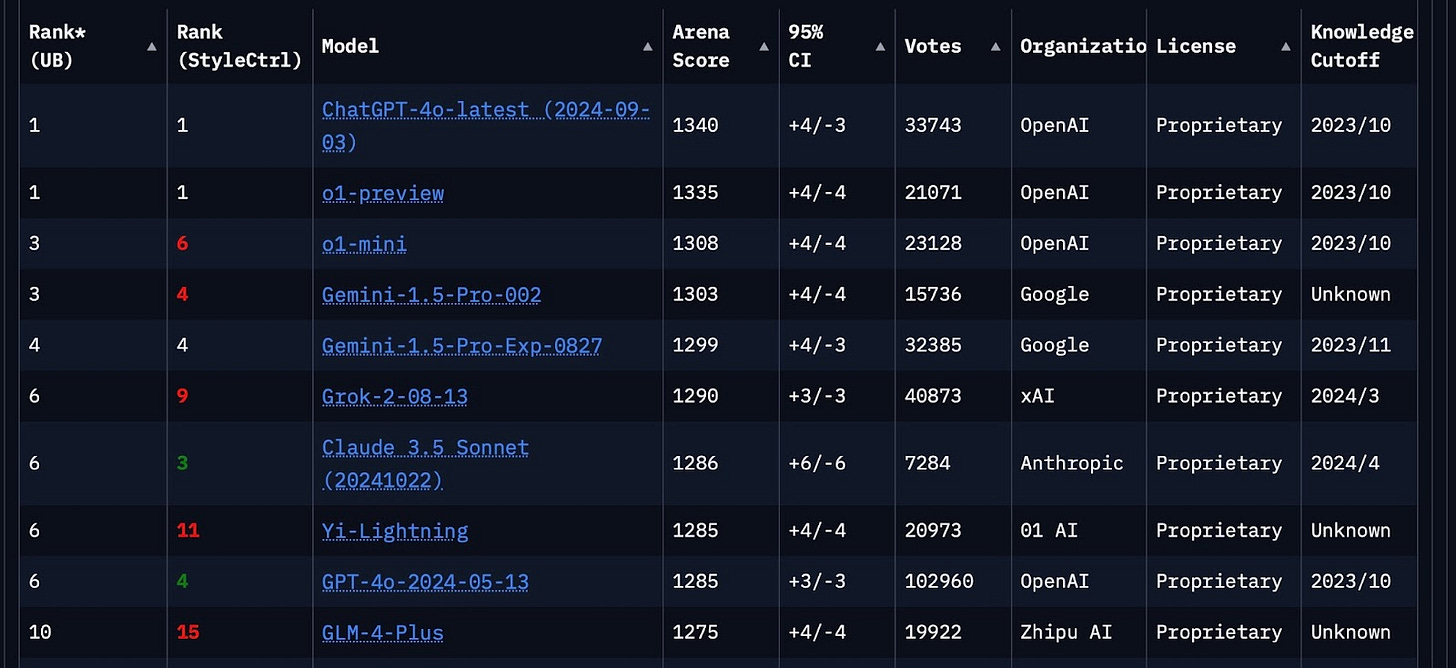

Los leaderboards comparan prestaciones de los diferentes LLMs. Uno de los más referenciados es Chatbot Arena, de SkyLab y LMSYS. Aquí la clasificación se establece mediante aproximadamente 1.5 millones de votos humanos y un sistema de clasificación Elo, similar al que se emplea en ajedrez. ChatGPT 4o encabeza el ranking general, no muy por encima de Gemini 1.5 (diferencias que se con toda probabilidad se acortarán cuando en diciembre Google presente Gemini 2.0).

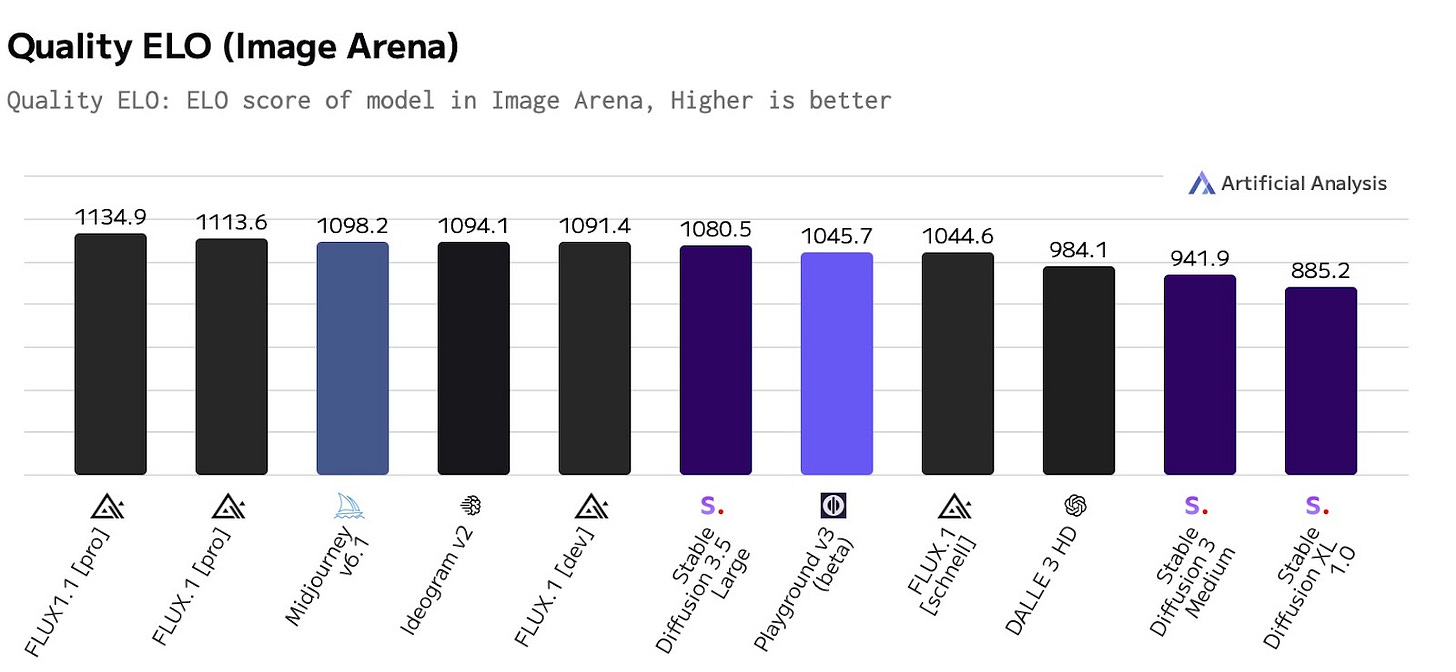

La equiparación de prestaciones no se da sólo entre los LLMs: también entre las herramientas de creación de imágenes y vídeos. Veámoslo en otro indicador muy referenciado, el de Artificial Analysis. Aquí también los usuarios votan. Y es Flux, y no Midjourney, el que consideran el mejor generador de imágenes (en otras palabras, el más popular no se considera como el que ofrece las mejores prestaciones). Incluso un recién llegado como Ideogram se sitúa casi al mismo nivel que Midjourney.

Código abierto: “No hay foso defensivo (no moat)”

Un email interno filtrado en Discord en mayo de 2023, supuestamente procedente de un ingeniero de Google, alertaba de que los modelos open source terminarían ganando la batalla frente a las Big Tech. Ni Google ni OpenAI podrían defenderse del acceso a ingentes cantidades de datos de acceso público y al abaratamiento de la capacidad computacional para entrenar los modelos de IA.

Matt Rickard predecía ya hace meses que los modelos fundacionales se convertirían en commodities. Aunque existen riesgos legales y de reputación para quienes los liberen como código abierto (caso de Meta), algunas empresas asumirán estos riesgos para lograr mayor distribución. La competencia será intensa, con startups, proveedores de hardware y grandes empresas buscando una ventaja competitiva.

Estos modelos fundacionales permiten cambios sencillos entre diferentes proveedores, lo que facilita la migración de clientes y reduce la fidelización. De hecho, muchos de los desarrollos internos que se están haciendo en grandes corporaciones habilitan justamente la función de poder trabajar con uno u otro modelo, conectándose a las diferentes APIs o usando los modelos open source instalados en la nube corporativa. Y no ocurre sólo en entornos corporativos. La semana pasada, GitHub anunciaba la integración de varios LLMs en GitHub Copilot. GitHub se compromete con la multimodalidad, y los usuarios podrán elegir ahora entre Claude 3.5, Gemini 1.5, o1-preview y o1-mini para generar código, según sus necesidades.

Pero meses después de la predicción de Rickard, es evidente que OpenAI sigue teniendo una ventaja sobre los competidores y el número de suscriptores de pago no deja de crecer. Un modelo IA open source es de libre acceso, sí, pero conlleva unos costes asociados: hardware para hacerlo funcionar, talento para operar y perfeccionar los modelos… Incluso el coste no fácilmente contabilizable de una UX más compleja, muchos menos intuitiva que la que traen los modelos comerciales, que exigen más tiempo y dedicación.

Lo cierto es que ni Anthropic ha sido capaz de mantener el ritmo de lanzamiento de funcionalidades que OpenAI ha introducido en estos meses… El modelo o1, la voz avanzada, dall-e (imágenes) integrado, … Yo uso y pago Claude, pero no dejaría de pagar ChatGPT, por ahora, y si tuviera que elegir entre uno y otro, me quedaba con el primero.

Tal vez la dificultad para diferenciarse está en la última milla. Si ponemos el listón de la aplicación perfecta en 100, muchas de las empresas que desarrollan modelos IA disponen de los recursos necesarios para llegar al 90. Lo verdaderamente complejo es dar el salto de calidad del último 10. Como escribía Ben Evans hace unas semanas:

Waymo acaba de recaudar otra gran ronda de financiación, lo que la sitúa en un total de 11.100 millones de dólares. Esto podría ser una lección para los investigadores de LLM más excitables: el aprendizaje automático nos llevó de la autonomía que no funcionaba a la autonomía que funciona el 90% del tiempo, pero el último 10% nos está llevando una década y aún no estamos cerca de la meta.

¿Será la IA un producto final o una infraestructura tecnológica?

Hemos mencionado varias veces por aquí el debate que existe sobre si la inteligencia artificial terminará siendo una infraestructura, una tecnología de apoyo, o un producto autónomo. En este último extremo, los "maximalistas" ven la IA como una entidad capaz de sustituir software tradicional, capaz de resolver tareas complejas a través de interfaces universales como los chatbots. Esta visión proyecta que la IA, con capacidades multimodales y multiagente, no solo complementará sino reemplazará las herramientas tradicionales con un único canal de interacción. Este es el objetivo que OpenAI persigue con ChatGPT. Y por ahora no les va mal. Alrededor del 75% de los ingresos de OpenAI proceden de usuarios finales. Actualmente, ChatGPT tiene 250 millones de usuarios activos semanales, un 25% más que en agosto. La empresa ha convertido entre el 5% y el 6% de los usuarios gratuitos a su versión de pago, que cuesta a partir de 20 dólares al mes.

Sin embargo, una perspectiva cada vez más común (la que está detrás de la estrategia de Apple, por ejemplo) plantea que la IA generativa es una tecnología de soporte o infraestructura: una pieza clave, pero no visible, de sistemas complejos. Aquí, la IA se integra dentro de aplicaciones y entornos que ya poseen un contexto profundo sobre el usuario, como sistemas operativos o aplicaciones verticales. Desde esta perspectiva, los modelos de IA no deben ser visibles ni independientes; en su lugar, se integrarían en forma de características específicas, trabajando de manera eficiente y en segundo plano, sin una interacción directa con el usuario. La comoditización sería, en este segundo caso, invisible. Se produciría, pero no seríamos ni conscientes.

Desde mi punto de vista, ambos extremos del debate coexistirán: la IA como infraestructura (mucha de la IA que aporta ya valor a la sociedad lo es) y la IA como producto visible, como chatbot compañero de aventuras personales de todo tipo. Y por concluir, puede que incluso la comoditización de la tecnología (suele ocurrir con todas) no sea el debate interesante, si no explorar los casos de uso y encontrar nuevos productos basados en IA que se cuelan en la mente (y la cartera) del consumidor.

El próximo domingo, vuelvo a tu buzón,

Fernando.

Actualidad.

La lista mensual de FlexOS con las 100 aplicaciones de IA más utilizadas en el trabajo. Destaca el crecimiento de Perplexity, entendido más como herramienta de investigación que como buscador. Pero ojo, el tráfico de Perplexity es aún inferior al 0,1% del tráfico de Google. LINK

Tercera semana consecutiva (tras Claude/Computer Use y Google/Jarvis) con novedades importantes en el camino hacia agentes IA independientes, Ahora es Microsoft quien presenta Magnetic One, un sistema (open source) que coordina múltiples agentes capaces de abordar tareas complejas del mundo real, como escribir código, manejar un navegador o pedir comida en un restaurante. MICROSOFT

El otro día hablamos de Decart, una startup israelita de generación de vídeo que ha sido capaz de generar espacios 3D en tiempo real en Minecraft, pero no mencionamos la empresa de chips detrás de la proeza (generar vídeo 10 veces más eficientemente que Sora, por ejemplo). El modelo se ejecuta en Sohu, una tecnología AI ASIC que Etched está desarrollando. (Ojo al tema de uso de energía y los incentivos para reducir drásticamente las necesidades energéticas que hoy tiene la IA para ser ejecutada). LINK

Reflexiones.

El 20 de noviembre se cumplen dos años del lanzamiento de ChatGPT. Su éxito inmediato sorprendió a los propios científicos de OpenAI, puesto que la tecnología ya estaba disponible desde 2018. Este artículo analiza los factores que hacen que una tecnología logre una adopción masiva. El éxito depende de factores psicológicos como la gratificación instantánea, la percepción de utilidad social y el deseo de pertenencia a una comunidad. LINK

Una periodista del NYTimes pasó una semana delegando todas sus decisiones en la IA generativa. Cuando se trata de ser eficiente en cuestiones prácticas, la IA Gen resultó imbatible: ganó tiempo y evitó muchas vueltas de cabeza. Pero (en conclusión), volvernos dependientes en exceso de la IA nos haría perder espontaneidad, y converger todos en las mismas decisiones. NYT

Mustafa Suleyman, CEO de Microsoft AI, tiene claro el roadmap de la IA para 2025. Veremos cinco grandes hitos: sistemas IA que se auto reparan, inteligencia emocional en la IA, agentes con visión (y por tanto, muchas más capacidades), memoria permanente para recordar todas las interacciones y lanzamientos de modelos grandes más poderosos junto con otros pequeños y específicos para tareas concretas. MARKETING INSTITUTE

The Future of AI. Una colección de artículos del Financial Times. FT.COM

¿Qué pasaría si resultara que la IA termina siendo beneficiosa para Hollywood? NYT

MCX.

The Intersection of Marketing, Data and AI: estudio de Hubspot y LinkedIn sobre la adopción de la IA entre más de 2.300 profesionales europeos de marketing. Aborda temas como la personalización, la mejora del CX, la calidad del dato y el seguimiento y medición de campañas. HUBSPOT

Los diseñadores del futuro tienen que incorporar un elemento nuevo: ya no diseñarán solo para personas, también para agentes, capaces de llevar a cabo acciones de manera independiente. De la UI (User Interaction) pasaremos a la ACI (Agent Computer Interaction). El artículo sugiere que el diseño UX debe evolucionar, adaptando técnicas como los "mapas de experiencia agéntica", para incluir las necesidades y capacidades de los agentes, manteniendo el control y transparencia para los usuarios humanos. LINK

Disney ha creado una unidad bautizada Office of Technology Enablement, para gestionar el uso de la IA y la Realidad Extendida (XR) en sus divisiones de cine, televisión y parques temáticos. YAHOO

La Generación Z (los nacidos entre 1990 y 2005) piensa y actúa de forma diferente. Sus prioridades y convicciones no son las mismas que las de otras generaciones. Son descreídos respecto a la publicidad tradicional, sus canales de investigación y descubrimiento son redes, amigos o influencers. Son mobile-only, no mobile-first. Todo esto se traslada a la forma de diseñar productos digitales dirigidos a ellos. La diversidad y la inclusión no son añadidos, sino que la dan por hecha. LINK

¿Podría la IA recuperar la calidad perdida en la atención al cliente? THE ECONOMIST

Herramientas IA.

Una de esas herramientas que pertenecen a una categoría que menciono en charlas sobre el impacto de la IA en la automatización de procesos y extracción de datos. Midship extrae datos de documentos PDF, hojas de cálculo y mucho más para introducirlos en las aplicaciones y sistemas de información preferidos. LINK

Y Bidcrunch, que da soporte en la preparación de ofertas para organismos públicos en Europa. LINK

Kling AI ha presentado Custom Model: para crear personajes más consistentes y realistas, podemos subir entre 10 y 30 vídeos (y no fotos) de hasta 10 segundos de un personaje . El modelo los toma cono una especie de entrenamiento intensivo, y después le pedimos en un prompt la escena que queremos que represente ese personaje. LINK

Hume es una startup especializada en crear voces con diferentes emociones para experiencias en contextos particulares. La he demostrado muchas veces en mis clases desde hace años. Ahora anuncian EVI-2, muy impresionante. LINK

Off Tópicos.

Una gran representación visual de la popularidad de las redes sociales durante los últimos veinte años. Por el camino han quedado nombres como Vine, Myspace, Friendster o Tumblr, todas con sus momentos álgidos antes de difuminarse. Otras, como Instagram, Pinterest, LinkedIn o X/Twitter han tenido -y tienen- perfil de montaña rusa. Reddit es un caso excepcional: no ha parado de crecer desde 2005 (+30 millones de usuarios activos nuevos en el último año). Su éxito se explica por los subreddits, foros especializados que crean sentimientos de comunidad y encuentro. Ahora además incorpora la IA para seguir creciendo (por ejemplo, las traducciones automáticas del inglés a otros idiomas) y sus foros se utilizan para entrenar los modelos de lenguaje de Google. LINK

Gracias por el ejercicio de NotebookLM, muy interesante.

Fernando, sobre el comentario de los _modelos abiertos_, ¿crees que estarán extendidos en entornos empresariales casi en exclusividad? ¿Serán también _commodities_ o serán los grandes desarrolladores (Anthropic, OpenAI, …) quien se llevarán el gato al agua?