La validez del dato cualitativo en la era IA.

El avance de la IA pone en duda un supuesto hasta ahora incuestionable en investigación cualitativa: que una respuesta coherente, lógica y contextualizada proviene de un ser humano.

Nunca hemos tenido tal cantidad de datos ni tanta capacidad de procesamiento analítico. Y sin embargo, la investigación de mercados y cualquier área de conocimiento que dependa de los datos recogidos en una encuesta se enfrenta a un desafío importante. El avance de la IA pone en duda un supuesto hasta ahora incuestionable en investigación cualitativa: que una respuesta coherente, lógica y contextualizada proviene de un ser humano.

Y vuelve a simultanear los roles de héroe y villano: la IA que amenaza la integridad de los datos, también es capaz de generar datos sintéticos de alta fiabilidad.

La sospecha en las respuestas online.

La capacidad de los LLMs para imitar de manera convincente a los humanos no es sólo un problema para la industria de investigación de mercado, ocurre algo similar en la educación, en los exámenes en remoto para certificaciones, en los procesos de recruiting.

Como demuestra la investigación de Sean Westwood, de la Universidad de Dartmouth, las salvaguardias tradicionales de la integridad del dato (verificación de atención, rompecabezas, análisis de patrones de respuesta) se han vuelto ineficaces. Fueron diseñados para desenmascarar bots simples y humanos poco atentos. No están preparados para enfrentarse a agentes razonadores que responden de forma sofisticada y consistente.

Las encuestas son una fuente primaria de datos en todas las ciencias, desde la medicina hasta la economía. En este estudio demuestro que la suposición de que las respuestas lógicamente coherentes provienen de seres humanos es ahora insostenible. Muestro que los agentes autónomos de IA, que operan a partir de una simple indicación, pueden evadir los métodos de detección actuales y producir respuestas de alta calidad en las encuestas que demuestran el razonamiento y la coherencia que se espera de las respuestas humanas. Esta capacidad compromete fundamentalmente la integridad de una herramienta crítica para la investigación científica, lo que crea una necesidad urgente de que la comunidad científica desarrolle nuevos estándares para la validación de datos y reevalúe nuestra dependencia de la recopilación de datos en Internet sin supervisión.

Westwood diseñó un agente IA capaz de completar encuestas online, imitando el comportamiento humano. Su tasa de éxito evadiendo los mecanismos de defensa fue casi total: superó el 99,8% de las verificaciones de atención, y no cayó en las trampas para detectar bots. No solo eso: el agente generó respuestas coherentes y plausibles (incluyendo respuestas complejas de texto abierto), prácticamente indistinguibles de las humanas.

Y centrándonos ahora en la investigación de mercado, a la imposibilidad de determinar si una respuesta online la ha generado un bot, se le suma otro tipo de riesgo, aún más capcioso, el del gig worker aumentado con IA. Según una investigación de Stanford, casi un tercio de los participantes en paneles online utiliza IA para redactar respuestas abiertas. De esta forma ganan velocidad en un trabajo que generalmente se paga por volumen. Puesto que los LLMs tienden a las respuestas neutras y asépticas, sin matices ni contradicciones, el resultado oculta la diversidad de opiniones reales y puede proyectar una falsa sensación de consenso o armonía en cualquier tema.

Entonces, ¿descartamos la investigación online?

Este tipo de manipulaciones, combinadas con un coste operativo cercano a cero, permiten un modelo de negocio fraudulento fácilmente escalable, que alienta la desinformación y las malas decisiones estratégicas: ¿estamos refrendando propuestas de valor con opiniones viciadas? ¿Tomamos decisiones (brand tracking, estudios de percepción, NPS, estrategias de contenidos, etc) que justificamos con datos extraídos de respuestas perfectamente verosímiles… generadas por nadie?

¿Debemos entonces descartar la investigación online, y volver a métodos tradicionales, lentos y caros pero fiables? Podría ser: la verificación convertida en un nuevo lujo. En un mundo saturado de señales digitales baratas y fácilmente manipulables, lo analógico vuelve como sinónimo de verdadero: paneles de confianza con clientes verificados, contacto físico como método premium para localizar trazas de humanidad. La inversión en confianza y privacidad se convierte en barrera que protege de la polución al dato.

Pero como decíamos, el panorama sombrío incluye, afortunadamente, un anverso luminoso.

El LLM como generador de datos válidos.

La misma tecnología que envenena la recolección de datos puede simular consumidores sintéticos capaces de reproducir reacciones humanas con una fidelidad sorprendente si se les alimenta con los contextos adecuados, como demuestra una investigación de PyMC Labs.

El método consiste en una tecnología llamada Calificación por Similitud Semántica (SSR) que transforma la respuesta abierta de un consumidor sintético (moldeado según atributos demográficos específicos) en un vector numérico (embedding). Luego, compara ese código con una escala Likert (como las de “totalmente de acuerdo” a “totalmente en desacuerdo”) resultando en una distribución de probabilidad en lugar de un número único, lo que captura mejor los matices de la respuesta humana.

La validez del método SSR se probó al compararse con datos humanos de 57 encuestas, alcanzando un 90% de fiabilidad. Un detalle clave fue dotar al LLM de información demográfica detallada (edad, gustos, etc.) del “consumidor”, ya que sin ella la precisión caía al 50%, confirmando la importancia de crear perfiles completos para obtener resultados válidos.

El difícil equilibrio al que nos enfrentamos.

El contraste entre estas dos investigaciones nos muestra que, aunque utilizan tecnologías similares, sus objetivos, metodologías e implicaciones son diametralmente opuestos. El enfoque de Westwood trata al LLM como un agente deshonesto, que busca el engaño y debe ser detectado y eliminado. En cambio, PyMC convierte al LLM en un simulador capaz de replicar las distribuciones de respuesta humana de forma convincente. Esta diferencia define el doble filo de la IA en la investigación social. No podemos ni adoptarla ciegamente ni renegar de ella.

Los gemelos digitales de clientes son excelentes para el prototipado rápido, pero peligrosos en la proyección financiera. Un modelo estadístico no es un mercado vivo. El consumidor sintético no tiene fricción, ni miedos irracionales y, sobre todo, no puede sorprendernos. Es un buen sparring, pero un oráculo cuestionable. Útil para explorar y filtrar hipótesis, peligroso para validar decisiones estratégicas. La IA es extraordinaria analizando lo que decimos los humanos (analizando y sintetizando discursos, detectando patrones, etc). No tanto simulando lo que sentimos y hacemos.

El próximo domingo, volvemos a tu buzón.

Fernando y Carlos.

Hace un año por estas fechas anunciábamos desde Good Rebels la creación de Kuantik, una división especializada desarrollo de soluciones IA. Tres nuevos socios, Álvaro Fernández, Miguel Calle y Víctor Martínez se sumaban a Kike Valdenebro y Mar Castaño para crear un área que combina estrategia de negocio, gestión y análisis de datos, diseño de experiencia e interfaz de usuario, arquitectura tecnológica y desarrollo tecnológico.

Un año después, el área no ha dejado de crecer, abordando proyectos impulsar el crecimiento y la competitividad de nuestros clientes y mediante el uso estratégico de la IA y su aplicación a soluciones de software de marketing bajo demanda o herramientas SaaS como AI Rank o Rebel Mix.

Actualidad.

Claude Cowork es una adaptación de Claude Code para el gran público no técnico. Cowork traslada la capacidad de programación de Code a las tareas de oficina: puede organizar carpetas, crear hojas de cálculo o redactar informes analizando archivos locales. La gran novedad es su sencillez: basta con darle acceso a una carpeta para que funcione. De momento, solo en lista de espera para suscriptores Max y MacOS.

La IA de Gemini se integrará en una versión completamente renovada de Siri que llegará a finales de 2026. La alianza entre Google y Apple puede calificarse como histórica: deja atrás años de competencia feroz y el retraso de Apple en IA generativa. LINK

McKinsey ha incorporado casi 25.000 agentes IA para asistir a sus 40.000 empleados, con el objetivo de que cada consultor disponga de al menos un asistente antes de año y medio. Por otro lado, la consultora está dejando atrás su modelo de honorarios por servicios y adoptando un sistema de riesgo compartido, involucrándose en los resultados finales de los proyectos de IA que implementa. BUSINESS INSIDER

La IA está detrás de 4 de los 5 puestos con mayor demanda laboral actualmente en EEUU, según el índice Jobs on the Rise 2026 de LinkedIn: Ingeniero de IA (1º), Consultor de IA (2º), Anotador de Datos (4º) e Investigador de IA/ML (5º). El mensaje es claro: la destreza en IA se está convirtiendo en elemento diferenciador.

Reflexiones.

Open AI y Anthropic han desembarcado simultáneamente en el sector sanitario: tras años de cautela por la rigidez regulatoria y el peligro de las alucinaciones, ambos coinciden en que sus modelos ya son lo suficientemente estables. No se busca sustituir el juicio clínico, sino resolver el caos de información fragmentada que hoy satura a médicos y pacientes. La diferencia es estratégica: OpenAI apuesta por ChatGPT integrado en la vida diaria, mientras que Anthropic opta por insertar Claude en flujos de trabajo ya existentes. LINK

La IA nos hace ya más productivos a los individuos, pero les sigue fallando a las organizaciones. El problema no es tanto técnico como organizativo: procesos sociales de coordinación, negociación y escalado. Para que la inteligencia pueda aportar, los agentes deberían integrarse como participantes en los sistemas reales de trabajo, usando las herramientas que usan los trabajadores. La historia demuestra que el progreso escala cuando la colaboración se vuelve explícita. La IA multi-agente no automatiza roles, aprende el contexto social, redistribuye la coordinación y nos obliga a rediseñar la organización. LINK

La rumoreada compra de Pinterest por Open AI serviría para añadir a ChatGPT capacidades visuales para mejorar la experiencia de compra. Con 600 millones de usuarios (50% Gen Z) y un taste graph irreplicable en la predicción de tendencias, Pinterest ofrece a OpenAI el catálogo de productos y la red de anunciantes necesaria para monetizar su base de usuarios gratuitos. LINK

Una pieza que explica en profundidad el protocolo MCP. THE VERGE

Research.

Según el estudio Beyond Productivity: Measuring the Real Value of AI de Workday, las ganancias de productividad que nos da la IA chocan con la realidad del "retrabajo": por cada 10 horas que la tecnología ahorra, se pierden casi cuatro corrigiendo resultados mediocres o incorrectos. El error de muchas empresas es medir la eficiencia bruta (tiempo ahorrado) en lugar del valor neto, ignorando que una tarea que se hace rápido pero mal no es progreso, sino una carga adicional.

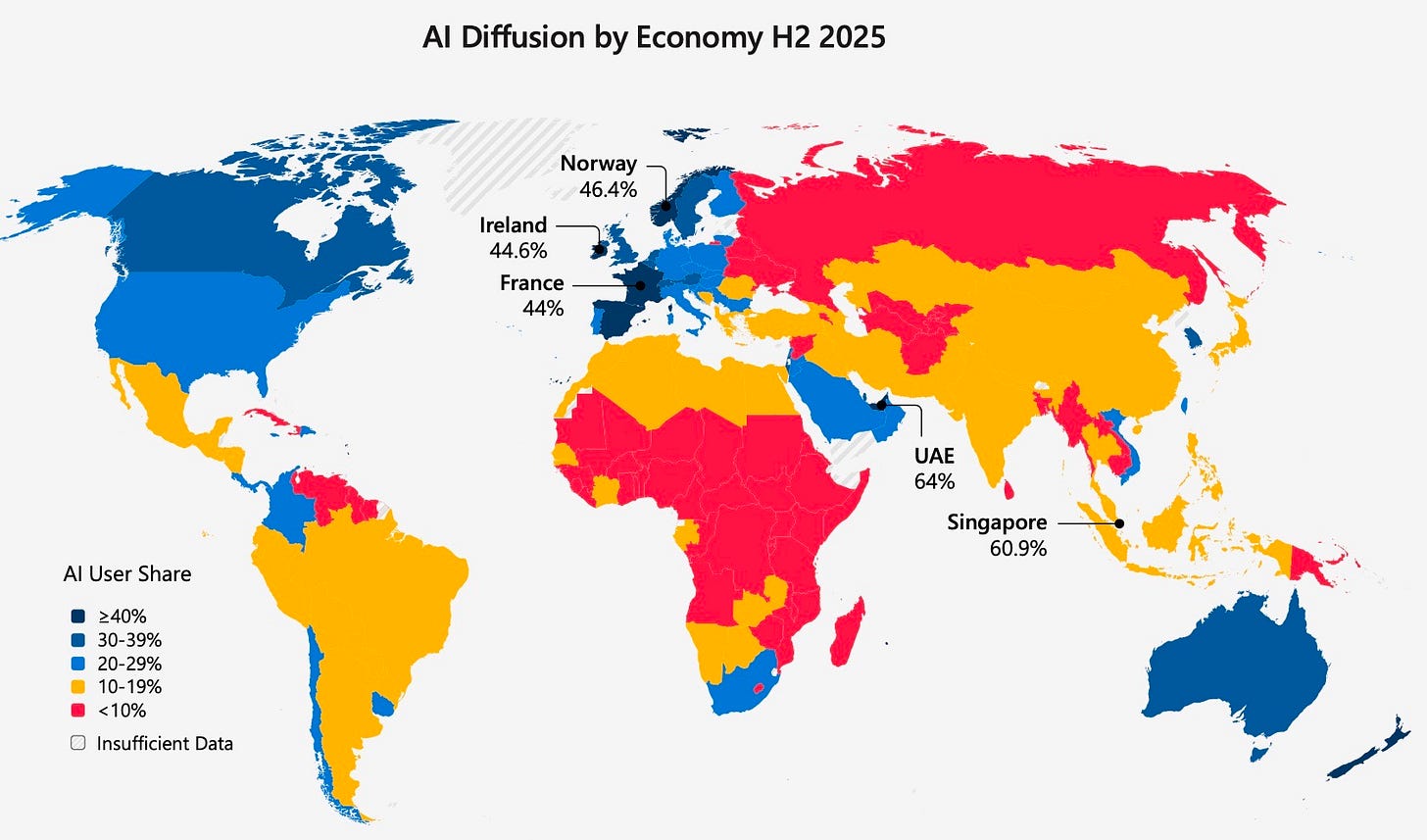

El estudio Global AI Adoption de Microsoft sitùa a España como el sexto país en adopción de la IA generativa: más del 41% de la población la ha utilizado. EEUU ocupa el puesto 24 y China no aparece entre las 30 primeras, mostrando la divergencia entre innovación y adopción.

Estudio de Harvard y Perplexity sobre los usos de Comet y su asistente integrado de IA. El 57% de la actividad son tareas cognitivas (36% productividad y trabajo, 21% aprendizaje e investigación), un 21% entretenimiento, y un 11% compras. El patrón de adopción es claro: el usuario llega por curiosidad (pidiendo una recomendación de viaje), pero se queda por la utilidad (depurando código o sintetizando informes financieros). PERPLEXITY

MCX.

Hablaremos de esto en breve, como continuación a nuestro artículo de la semana pasada. La IA se integra en un juguete existente y se convierte en un producto nuevo. Los niños ya no se limitan a escuchar cuentos. Se meten en ellos, los dirigen y comparten escenario con personajes “inteligentes”. Bienvenidos a Evie’s Magical Tale. LINK

Google ha presentado Universal Commerce Protocol (UCP), un estándar abierto (respaldado por Walmart y Shopify) que permite a distintos agentes, empresas y métodos de pago hablar el mismo idioma. La joya de la corona es Business Agent, un asistente virtual con la "personalidad" de la marca que resuelve dudas y permite comprar directamente desde el buscador. Además, Google está añadiendo funciones de pago y anuncios dentro de Gemini. GOOGLE

Mientras tanto, Walmart también está incluyendo anuncios en su asistente de compras con IA, sumándose así a Rufus, de Amazon. WALMART, AMAZON

Colgate-Palmolive utilizó IA para eliminar los cuellos de botella en la producción de contenidos, creando vídeos entre 4 y 6 veces más rápido que con los métodos tradicionales con Veo, de Google. THINK WITH GOOGLE

Off Tópicos.

Craigslist sobrevive como un reducto anacrónico que reniega de algoritmos, perfiles públicos y notoriedad social. La web mantiene una estética espartana y una filosofía basada en el anonimato y la utilidad directa. Un espacio “puro” donde todavía es posible encontrar desde empleos surrealistas hasta viviendas asequibles sin la mediación de un software que decida qué debemos ver. WIRED

De esto va Deepmimic, el nuevo proyecto de José Luis Flórez con el que estoy colaborando. Dale un vistazo.

https://deepmimic.ai/

Muchas gracias Fernando/Carlos!! Como siempre, un resumen genial