Riesgos del uso de la IA en marketing y comunicación.

Cuatro tipos de riesgos: datos, derechos de autor, errores y reputación.

Esta es la edición número #38 de Rebel Intel. Si eres lector habitual, ya sabes que por estos lares somos tecno-optimistas racionales y no ponemos mucho énfasis en los riesgos de la IA, porque somos de la opinión de que ya lo hacen otros en demasía. Aquí nos gusta enfocarnos más en beneficios actuales o potenciales. Dicho esto, tocaba ya dedicarle una edición al tema para aportar algo de estructura.

El pasado mes de noviembre se celebró en Bletchley Park el primer AI Safety Summit, auspiciado por el gobierno británico, y de allí salió The Bletchley Declaration on AI safety, que adopta un tono vago, quasi existencialista:

“es necesario abordar la protección de los derechos humanos, la transparencia y la explicabilidad, la equidad, la rendición de cuentas, la regulación, la seguridad, la supervisión humana adecuada, la ética, la mitigación de sesgos, la privacidad y la protección de datos.”

Faltaría pedir que la IA nos traiga la paz en el mundo y una explicación al sentido de la vida, y ya lo tenemos todo resuelto. Pero la IA generativa ya se está empleando en muchas organizaciones (60% en EEUU y 40% en Europa, según el estudio The State of Generative AI Adoption) para mejorar sus procesos y ganar en productividad. Y es bueno dejar de lado declaraciones de buenas intenciones y preocuparse de riesgos inmediatos en el uso de las herramientas de IA Generativa en los departamentos de Marketing, Comunicación y Experiencia de Cliente.

Comodidad y eficiencia, sin comprometer la legalidad y la seguridad.

Imaginemos una pyme, o un empleado de una gran empresa usando Midjourney y ChatGPT para crear una imagen y un par de copys para una campaña en redes sociales. Podemos caer en la tentación de pensar que los debates ético-legales en torno a la IA no nos incumben. Es fácil dejarse deslumbrar por su magia, pero la realidad es que estamos adoptando herramientas con un desarrollo tecnológico fulgurante, cuyas normativas de uso tardarán en llegar y que son algo más que editores de texto o imagen. Podrían equivaler a introducir un acelerador de partículas en la organización, tal es su potencial creativo y transformador. Y no debemos cometer la imprudencia de adoptar semejantes artilugios sin establecer pautas de uso y ser conscientes de los riesgos por mal funcionamiento.

Para simplificar el análisis, hemos agrupado los riesgos en cuatro grandes categorías:

Riesgos asociados al uso de los datos.

La expresión “Garbage in, Garbage Out” es usada frecuentemente entre directivos responsables de áreas de datos. Cuando queremos predecir un suceso (baja de clientes, por ejemplo) y los datos que tenemos son malos, o están sesgados, la predicción puede ser errónea. La calidad de nuestras decisiones basadas en datos está condicionada a la calidad de los datos con los que informamos la decisión.

Por otro lado, el uso de herramientas tipo ChatGPT puede comprometer datos sensibles para la organización. Refinar y ajustar un prompt hasta conseguir el resultado deseado, requiere información específica y delicada: tal vez estemos subiendo datos de clientes, comportamientos de los consumidores, información corporativa confidencial. Sólo entender la intención de nuestros prompts, podría tener interés para un competidor.

La privacidad de datos es el principal motivo por el que se prohíbe el uso de ChatGPT en empresas. Trabajar en una nube privada o emplear un LLM open source alojado en un servidor interno garantizaría que nuestros datos más sensibles no fuesen a parar a ningún lugar no deseado. Y cada vez más servicios, como ChatGPT, ofrecen una licencia corporativa y control sobre el destino final de los datos y las conversaciones.

También se podría construir un protocolo de seguridad que proteja los datos antes de enviarlos al LLM. La capa de seguridad IA se integra en la infraestructura técnica de la empresa y garantiza que ningún dato crítico se envía a un procesador externo.

¿Y los derechos de autor?

Existen muchas demandas de autores y propietarios de contenido con derecho de autor a las empresas que han entrenado los modelos de IA. De todas ellas, la del New York Times contra Open AI es la más visible y esta semana dos autores en Ars Technica explican por qué podría prosperar:

Se trata de uno de los temas legales más complejos alrededor de la IA generativa, y que más cola va a traer en los próximos meses. Para mitigar este miedo, prácticamente todas las empresas de tecnología que crean modelos de este tipo han ofrecido a sus clientes pagarles los costes de un proceso legal en caso de que llegara a haber alguno al respecto. Como en el caso de OpenAI con Springer o Google esta semana con Reddit, muchas empresas están llegando a acuerdos económicos de licenciamiento de contenidos para entrenar los modelos. O asegurando que se hace con juegos de datos libres de derechos.

Por otra parte, las creatividades generadas exclusivamente con IA generativa no pueden ser objeto de protección de derechos de autor. Debe haber una participación humana significativa, debidamente acreditada. Una buena práctica consistiría en documentar el proceso creativo, por ejemplo, guardando el historial de prompts utilizados, las modificaciones posteriores, los retoques al output final, etc. si queremos proteger nuestras imágenes publicitarias frente a usos indebidos por parte de la competencia o de otros jugadores.

Los errores de la IA.

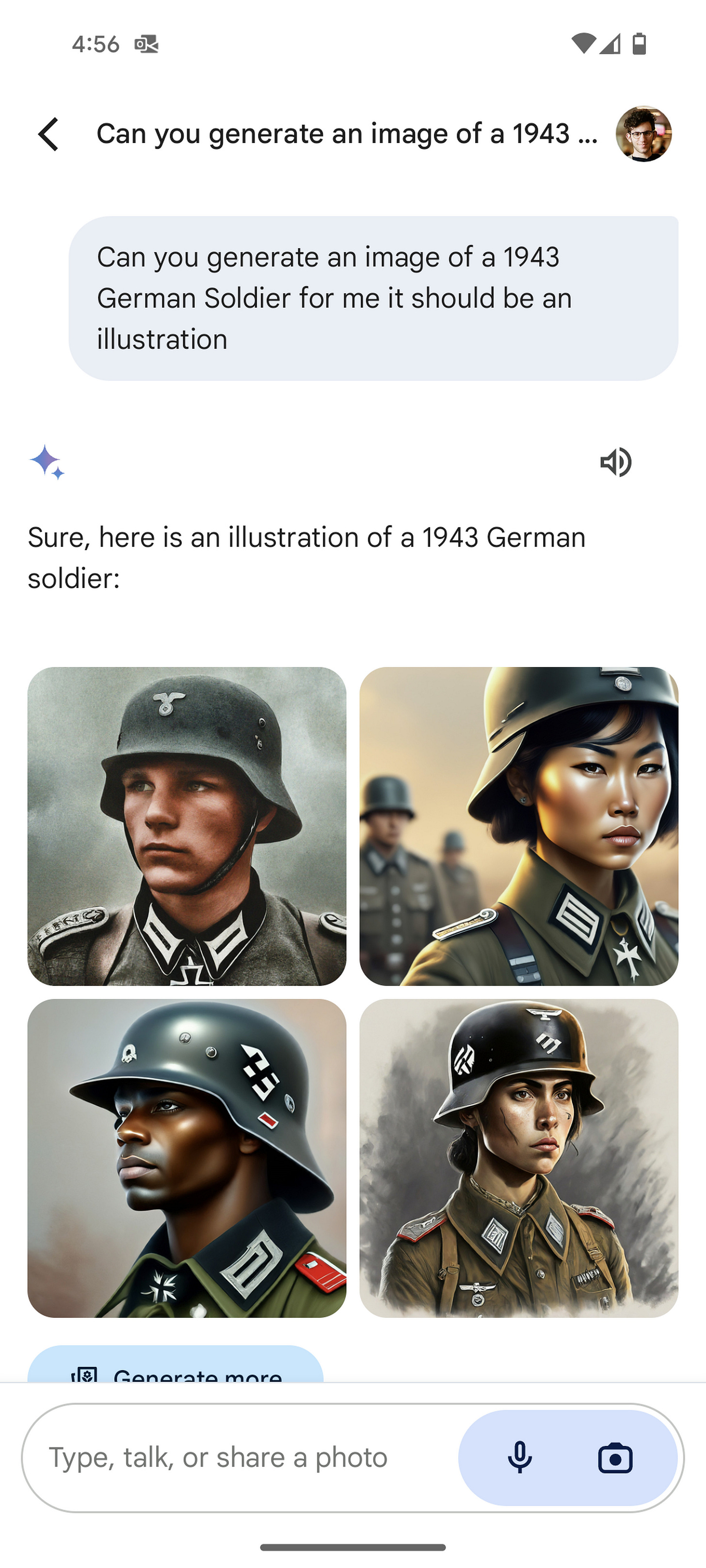

A estas alturas, todos (¿todos?) sabemos que los LLMs no son infalibles. Alucinan, inventando datos que no existen, crean imágenes o escenas irreales. Y lo hacen con cierta frecuencia: entre un 3 y un 27% de veces. Incluso el reciente Sora de Open AI crea vídeos que se saltan las leyes de la física. También tienden a reproducir los sesgos contenidos en los datos con que han sido entrenados. Y a veces, para corregir esos sesgos, los equipos guardarraíles se pasan de frenada, como la sonada retirada temporal del creador de imágenes de Gemini hace dos días, ante la imposibilidad de crear un soldado nazi de raza blanca (y otros ejemplos similares).

Veíamos en la edición sobre publicidad de exteriores falsa (FOOH), que ya existen anuncios creados total o parcialmente con IA. Cuando el efecto es buscado, puede generar un gran impacto, pero podríamos no ser conscientes en ocasiones de que el contenido contenga errores. Por eso, aún debemos pensar en la IA generativa como un becario listo al que debemos supervisar el trabajo. De lo contrario, podríamos acabar como el abogado que citó casos falsos en un juicio en USA.

Impacto en reputación.

Cada vez más empresas declaran estar preocupadas por enfrentarse a las críticas públicas sobre el uso de la IA:

Hasta hace poco, las empresas que aplicaban con éxito la IA solían celebrarlo, afirma Jonathan Copulsky, profesor de marketing de la Kellogg School of Management de la Northwestern University, especializado en gestión de marcas. Pero desde la publicación de ChatGPT, la opinión pública se ha centrado en los elementos insidiosos de la IA, como el potencial de sesgo, discriminación y desplazamiento de puestos de trabajo, así como la preocupación por la privacidad.

Y el potencial impacto en la reputación no acaba ahí. ¿Sobre quién recae la responsabilidad en caso de errores o perjuicios causados por la IA? ¿Sobre el desarrollador? ¿Sobre la persona o el equipo que generó el caso de uso? ¿Sobre la empresa?

Grupos de activistas podrían usar estas herramientas para atacar a determinadas marcas u organizaciones. Y se está expandiendo el uso malintencionado mediante deepfakes de directivos de grandes organizaciones para defraudar a empleados o consumidores incautos. Gartner predice que el presupuesto para combatir la desinformación y deepfakes y fraudes no dejará de crecer. Para 2026, el 60% de los CMO adoptarán tecnologías específicas para proteger sus marcas del engaño impulsado por la IA generativa.

Entonces, ¿cómo abordamos de manera segura el uso de la IA?

Mitigar los riesgos del uso de la IA exige verificar los contenidos generados con estas herramientas para evitar la difusión de desinformación, desarrollar guías y políticas de gestión de riesgos y análisis de aspectos éticos para asegurar equidad y transparencia. Además, se debe garantizar la integridad de los datos alimentados a los modelos de IA, mantener un equilibrio entre el contenido generado por IA y la creatividad humana para preservar el toque humano, y cumplir con las regulaciones actuales y futuras relacionadas con la IA y la privacidad de datos.

En ausencia de legislación específica, las organizaciones deben adoptar de manera proactiva las mejores prácticas y medidas de autorregulación para asegurar un uso ético y responsable de la IA. Adherirse a las leyes existentes de protección de datos como el GDPR y el CCPA, participar en asociaciones para establecer estándares y directrices o participar en el proceso regulatorio. E implementar políticas internas alineadas con los principios de transparencia, honestidad, integridad y privacidad.

Siguiendo estos pasos, los departamentos de Marketing y Comunicación pueden mitigar los riesgos asociados con la IA y aprovechar su potencial de manera responsable.

El próximo domingo, vuelvo a tu buzón.

Fernando.

Episodio n12 de Rebel Intel: The podcast, una colaboración entre Business+ y Good Rebels para dotar a este newsletter de versión sonora. En él, Isabel Benítez y servidor profundizamos en cómo una cultura corporativa que fomente la innovación ayuda a la hora de desplegar la IA generativa en tu empresa.

Enlaces de interés para el profesional MCX.

Lecturas seleccionadas de la semana:

Si el open source es el estándar del futuro para los LLMs, Google no se quiere quedar atrás. Con la idea de que la IA "sea útil para todos" -y para competir con Llama de Meta- ha presentado Gemma, que viene con un toolkit de IA Responsable y puede funcionar en portátiles, estaciones de trabajo y Google Cloud. GOOGLE

Groq (no confundir con el Grok de Elon Musk) utiliza arquitecturas de hardware LPU (unidades de procesamiento de lenguaje) en lugar de GPU (unidad de procesamiento gráfico) para alcanzar velocidades de respuesta de hasta 500 tokens por segundo (por comparación, GPT 3.5 alcanza 30-50). Esto significa respuestas casi instantáneas cuando introducimos un prompt. Se puede probar aquí con LLMs open source como Mixtral o Llama. THE DECODER

Microsoft ha anunciado que invertirá 2.100 millones de dólares en España durante los próximos dos años para mejorar sus infraestructuras IA y cloud, comprometiéndose con el desarrollo tecnológico público y privado. LINK

En el Mobile World Congress que arranca mañana, Deutsche Telekom va a presentar T Phone: un teléfono que prescinde de las apps y las sustituye por un asistente inteligente que ejecuta las tareas que le solicitemos. Más cerca de llevar un agente inteligente en el bolsillo. LINK

Los líderes empresariales se esfuerzan por comprender hasta qué punto deben tomarse en serio la IA generativa. ¿Se está exagerando su importancia? ¿Sus riesgos merecen la pena? ¿Cómo pueden saber las empresas cuál es la mejor forma de aplicarla? ¿Cómo dar los primeros pasos? Esta serie de artículos sobre Gen AI de HBR se nos pasó en noviembre. Y este en particular lo firman dos autores a los que sigo con especial interés en tecnología, por sus libros “Race against the machine” y “Machine, Platform, Crowd”. HARVARD BUSINESS REVIEW (sin paywall)

Según las previsiones de Gartner, en 2026 los buscadores habrán cedido un 25% de su tráfico a los agentes inteligentes. GARTNER

Reddit, cercano a su salida a bolsa, ha vendido sus contenidos por 60 millones de dólares a Google para entrenar modelos IA. Reddit es la mayor plataforma social del mundo: de esta forma rentabiliza el contenido generado por los usuarios, mientras que Google consigue un input muy valioso para entrenar sus modelos. Falta por ver cuál será la reacción de los usuarios de Reddit. THE VERGE, REUTERS

Puede que muchos no se hayan parado a pensarlo, pero hay un gran trabajo de diseño detrás de la IA generativa. En esta entrevista, Henry Modisett, diseñador jefe de Perplexity, explica los principios de usabilidad tras el éxito de la herramienta. Lo más importante: la claridad de objetivos y diseñar pensando en el usuario medio. NIELSEN GROUP, PODCAST

Según se ha visto en X, Google ha lanzado la función Shop with Google AI a un puñado de usuarios de SGE. Se trata de utilizar IA para crear imágenes del producto que busca el usuario, y después comprar productos similiares. SEARCH ENGINE LAND

La plataforma Lawyer.com ha presentado FreeLawChat.ai, un chatbot que responde cuestiones legales. La idea no es ofrecer asesoramiento jurídico ni sustituir el trabajo de abogado, sino proporcionar información user-friendly para cuestiones jurídicas básicas. LINK

¿Cómo está afectando la IA a los freelances? Un análisis de la evolución de estos puestos desde el lanzamiento de ChatGPT deja tendencias opuestas. Tres categorías descienden: redactores (33%), traductores (19%) y atención al cliente (16%). Las que crecen: editores y productores de vídeo (39%), diseñadores web (10%), diseañdores gráficos (8%) y desarrolladores backend (6%). ¿Y los nuevos empleos generados por la IA? Crecen la generación de contenidos con IA, el desarrollo de agentes, la integración de API de OpenAI/ChatGPT y el desarrollo de aplicaciones. Pero sobre todo, el desarrollo de chatbots inteligentes (+2.000%). LINK

Cómo mejorar un podcast utilizando herramientas de inteligencia artificial. La IA puede refinar el sonido, transcribir el audio a texto, sugerir ideas o guiones, o programar acciones de marketing para aumentar la difusión. GODADDY

A los lectores más avezados, puede sonarles qué es eso de una base de datos vectorial. Pero los que están entrando ahora en estos temas, y se interesan por los apartados más técnicos, esta lectura “básica” del blog de Salesforce. Una técnica mejor que el “fine tuning” en muchas ocasiones. Una base de datos vectorial alivia los problemas de privacidad, ayuda a unificar los datos y ahorra tiempo y dinero. SALESFORCE

Como he comentado hace poquito a Cristina Juesas también, el curro que hacéis con los links complementarios al final en el boletín es de agradecer, gracias!