Los cuatro pilares de la gobernanza IA en la empresa.

El uso de la IA en las organizaciones se dispara. Pero abordar el despliegue presenta muchos retos, si queremos encontrar el retorno a la inversión.

Esta semana impartía un workshop para el comité de dirección de una empresa industrial. Una empresa de tamaño mediano, muy singular (sin competencia, dependiente de un organismo público) y cuyo comité reconocía tener un conocimiento limitado de la capacidad transformadora de la IA. La primera parte la dedicamos a entender conceptos de la IA con foco en la IA generativa. En la segunda revisamos áreas de aplicación y casos de uso. Y en la tercera, nos centramos en formular y responder preguntas fundamentales sobre la gobernanza de la IA en una organización.

Hemos creído interesante compartir en esta edición de Rebel Intel, el modelo que utilizamos con nuestros clientes en los proyectos de despliegue de IA generativa que estamos abordando desde Good Rebels.

McKinsey señala en su reciente The State of AI que la IA generativa está teniendo una adopción meteórica: 33% en 2023, 65% en 2024 y 71% en 2025. Y el 78% de los encuestados utilizan IA en al menos una función corporativa, frente al 72% de hace un año y el 55% de 2023. Y la media se encuentra ya en tres funciones corporativas.

Existe sin embargo cierta tensión entre la urgencia por adoptar la IA y el nivel de preparación efectiva. El informe Cisco AI Readiness Index 2024 ofrece una radiografía reveladora sobre ese contraste. Prácticamente todas las organizaciones (98%) reportan urgencia, impulsada por la presión del liderazgo ejecutivo y los consejos de administración, la búsqueda de eficiencia y productividad, la necesidad de mantenerse competitivos y la priorización estratégica. Un 85% de las organizaciones considera que tiene menos de 18 meses -el 59% reduce el plazo a 12 meses- para demostrar el impacto de la IA antes de afrontar consecuencias negativas, como la pérdida de influencia en un futuro donde la IA va a ser omnipresente. Pero, ¿se ven preparadas?

¿Cuán preparadas están las organizaciones?

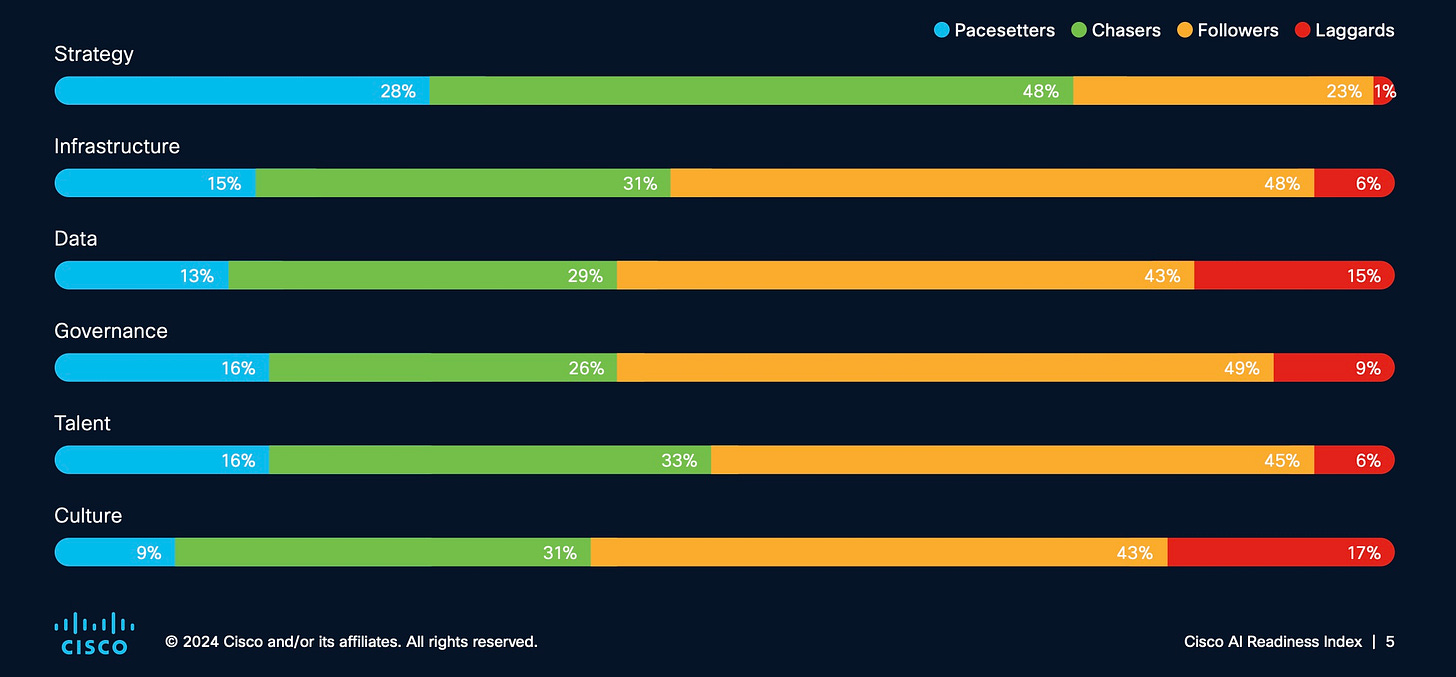

Cisco clasifica las empresas en cuatro categorías según su nivel de preparación IA: Pacesetters (totalmente preparadas), el 13%; Chasers (moderadamente preparadas), el 33%, Followers (preparación limitada), el 51%; y Laggards (no preparadas), el 3%.

Las empresas están claramente dispuestas a invertir en la adopción de la IA: el 50% ya dedica entre un 10% y un 30% de sus presupuestos IT, y la previsión para los próximos cinco años es que esta asignación se duplique, alcanzando el 30%. Pero tienen que superar importantes deficiencias estructurales y operativas en los seis factores que Cisco considera determinantes en la adopción de la IA:

Estrategia: el punto mejor cubierto. El 95% tiene una estrategia de IA bien definida o en desarrollo, siendo la ciberseguridad la principal prioridad.

Infraestructura: solo un 21% posee las GPUs necesarias y un 30% la capacidad de protección de datos adecuada. La escalabilidad y flexibilidad de las redes actuales son insuficientes.

Datos: la calidad y el preprocesamiento de datos siguen siendo retos mayúsculos. La fragmentación de datos afecta al 80%, y solo el 32% reporta alta preparación en la gestión de datos.

Gobernanza: menos de un tercio (31%) considera sus políticas de IA como exhaustivas. La falta de expertos en ética y cumplimiento normativo es un desafío para el 51%.

Talento: persiste un notable gap de habilidades. Únicamente el 31% confía en su talento interno, y un 24% adolece de personal insuficiente o no encuentra talento en el mercado.

Cultura: solo el 9% se consideran pacesetters en cuanto a preparación cultural. El 30% encuentra resistencia a la IA de sus empleados.

Los cuatro pilares de la Gobernanza IA.

Adoptar la IA a nivel corporativo, como demuestra con cifras el informe de Cisco, conlleva un nivel de complejidad sin precedentes. En la medida en que la IA tiene la capacidad de agitar los cimientos de una organización, es necesario orquestar este cambio con los objetivos, valores y el apetito de riesgo de la organización.

Podemos dividir o agrupar los grandes desafíos de implementación de la IA en cuatro áreas principales: organización y gestión del cambio, tecnología, procesos y responsabilidad.

1.- Organización y gestión del cambio: el factor humano en la ecuación.

Las tecnologías más avanzadas serán inservibles sin una actitud receptiva. La implementación de IA provoca un cisma en las formas de trabajar establecidas, generando resistencias y demandando nuevas habilidades. Para McKinsey, la implementación efectiva requiere un C-suite comprometido y un consejo implicado. Delegar la implementación únicamente al departamento de TI es una "receta para el fracaso".

Organización: es crucial establecer una visión clara desde la dirección y definir quién es responsable de qué. Esto a menudo implica la creación de comités de gobernanza y roles específicos dedicados a la supervisión de la IA. ¿Necesitamos un CAIO (Chief AI Officer)? ¿Cómo se gestionan los presupuestos? ¿Optamos por un modelo centralizado o descentralizado?

Talento y capacitación: identificar, atraer y, sobre todo, formar al talento interno (upskilling) es vital. La formación no es solo técnica: se necesitan traductores que conecten la IA con el negocio. Las comunidades de prácticas, donde se comparten conocimientos y experiencias, son un vehículo excelente para el aprendizaje colectivo. ¿Qué nuevos perfiles debemos incorporar? ¿Qué nuevas habilidades o servicios esperan nuestros clientes? ¿En qué áreas es prioritaria la inversión en IA?

Cultura y comunicación: crear espacios de experimentación y comunicar de manera transparente los objetivos, avances y riesgos de las iniciativas de IA es fundamental para gestionar la resistencia al cambio y difundir confianza.¿Cómo fomentar una cultura de experimentación responsable? ¿Qué canales son más efectivos para mantener a todos informados sobre las iniciativas de IA? ¿Cómo podemos medir la confianza y la aceptación de la IA?

2.- Procesos y adaptación: integrando la IA en el engranaje operativo.

McKinsey destaca que el valor real de la IA proviene de reconectar (rewiring) los flujos de trabajo de las empresas.

Selección y priorización de casos de uso: identificar las oportunidades donde la IA puede generar mayor impacto, evaluando costes, beneficios y viabilidad. ¿Priorizamos la IA por su potencial transformador real o sucumbimos al hype, persiguiendo casos de uso cosméticos sin impacto estratégico? ¿Quién tiene la última palabra en la selección de casos, el tecnólogo seducido por el algoritmo o el estratega con visión de negocio y cliente?

Integración en flujos de trabajo: adaptar los procesos existentes o diseñar nuevos para incorporar las capacidades de la IA de forma fluida. Esto puede ir desde la asistencia básica para aumentar la productividad personal hasta la interacción compleja entre humanos e IA para toma conjunta de decisiones. ¿Estamos "parcheando" procesos obsoletos con IA, o aprovechamos para un rediseño radical? ¿Hemos definido con precisión qué tareas delega, cuáles aumenta y dónde la IA es apenas un espectador? ¿Medimos el impacto real de la IA en la eficiencia y la calidad del output?

KPIs, monitorización y mejora continua: establecer métricas claras para medir el rendimiento y el impacto de la IA, y utilizar ciclos de feedback iterativos para refinar tanto los modelos como los procesos. ¿Hemos desarrollado KPIs específicos para medir la eficiencia o el valor tangible aportado por la IA? ¿Reinvierten los ahorros o beneficios generados por la IA en su propia mejora? ¿Cómo combatimos el model drift), o pérdida de eficiencia de los modelos IA?

3.- Tecnología y ciberseguridad: el andamiaje esencial.

La infraestructura tecnológica sobre la que se construye la IA debe ser sólida y al mismo tiempo adaptable. Una implementación de IA efectiva exige rigor técnico desde la concepción hasta el despliegue.

Arquitectura flexible y escalable: para crecer, la IA necesita una arquitectura tecnológica que soporte la experimentación rápida, pero también escalable y segura para adaptarse a la rápida evolución de los modelos y herramientas. ¿Es nuestra infraestructura actual un acelerador o un lastre para la adopción de la IA? ¿Nuestros sistemas legacy son una catedral tecnológica que fagocita la disrupción? ¿Sacrificamos robustez por velocidad de experimentación?

Calidad de datos: un viejo mantra del sector es “La IA es tan buena como los datos que la alimentan”. Asegurar la calidad, pertinencia y gestión adecuada de los datos es un requisito innegociable. ¿Quién es el verdadero dueño –y responsable– de la calidad del dato: tecnología, negocio, o una figura híbrida aún por inventar? ¿Estamos invirtiendo en la gobernanza del dato con la misma seriedad que en los algoritmos, o sigue siendo el pariente pobre de la estrategia de IA? ¿Cómo garantizar datos limpios, representativos y éticamente obtenidos?

Seguridad específica para IA: proteger los modelos, los datos de entrenamiento y los endpoints contra manipulaciones o robos es una prioridad absoluta. ¿Contempla nuestra estrategia de ciberseguridad nuevas amenazas inherentes a los modelos IA? ¿Estamos preparados para defendernos de una IA entrenada para explotar vulnerabilidades de sistemas? ¿Quién asume la responsabilidad cuando un error provoca un daño en el negocio o al cliente?

4.- IA Responsable: las balizas éticas, legales y de riesgo.

Este pilar asegura que la implementación de IA se realice dentro de un marco ético, cumpla con la normativa vigente y gestione proactivamente los riesgos inherentes.

Ética y equidad: Incorporar principios éticos desde el diseño: transparencia, explicabilidad (cuando sea posible), justicia y evitación de sesgos discriminatorios. ¿Nos quedamos con principios rimbombantes, o tenemos mecanismos concretos y auditables para detectar y mitigar sesgos? ¿Podemos explicar las decisiones críticas que toma la IA? ¿Cómo asegurar que la eficiencia y personalización de la IA respeten la justicia y la equidad?

Privacidad y consentimiento: garantizar el cumplimiento riguroso de las normativas de privacidad de datos, asegurando el consentimiento informado y el uso responsable de la información personal. ¿Reflejan nuestras políticas de privacidad la complejidad del uso de datos en IA (inferencias, datos sintéticos, reentrenamientos) o son un corta-pega obsoleto de la era pre-IA? ¿Es realmente "informado" el consentimiento que recabamos si desconocemos el uso futuro de los datos por la IA? ¿Podemos asegurar la privacidad y anonimización ante reguladores expertos?

Cumplimiento normativo: navegar el complejo panorama regulatorio y anticipar futuras legislaciones. Sin olvidar temas tan espinosos como la gestión de la propiedad intelectual y el copyright. ¿Navegamos el laberinto regulatorio (EU AI Act y similares) estratégicamente o con soluciones improvisadas? ¿Tenemos claro cómo gestionar la propiedad intelectual cuando la IA genera contenido a partir de fuentes protegidas? ¿Tiene el equipo legal las competencias técnicas necesarias para dialogar con desarrolladores de IA y anticipar riesgos?

Gestión de riesgos: identificar, evaluar y mitigar los riesgos asociados a la IA, que van desde inexactitudes y "alucinaciones" hasta riesgos reputacionales, deepfakes o la obsolescencia de roles laborales. ¿Incluye nuestro mapa de riesgos corporativos las nuevas amenazas específicas de la IA? ¿Tenemos planes de contingencia robustos para cuando la IA falle? ¿Cómo abordamos el riesgo estratégico –y social– de disrupción laboral que la IA acelera?

Esta semana, hablando con este comité directivo que admitía abiertamente su vulnerabilidad, comprobamos de nuevo que adoptar la IA va más allá de usar el Copilot de Microsoft, o implantar algoritmos y rezar por resultados milagrosos. No debemos saltar sin red, una buena definición del gobierno IA nos ayuda a mitigar el riesgo.

Desde Good Rebels hemos decidido trabajar en paralelo sobre estos cuatro pilares esenciales: gestionar con lucidez el factor humano, integrar con precisión los procesos, cimentar una infraestructura tecnológica ágil pero robusta, y gobernar éticamente la implementación. No hay atajos ni soluciones mágicas, solo preguntas incómodas y decisiones valientes.

El próximo domingo, volvemos a tu buzón.

Fernando y Carlos.

Hace unos meses anunciamos desde Good Rebels la creación de Kuantik, una división especializada desarrollo de soluciones IA.

Tres nuevos socios, Álvaro Fernández, Miguel Calle y Víctor Martínez se suman a Kike Valdenebro y Mar Castaño para crear un área que combina estrategia de negocio, gestión y análisis de datos, diseño de experiencia e interfaz de usuario, arquitectura tecnológica y desarrollo tecnológico para impulsar el crecimiento y la competitividad de nuestros clientes mediante el uso estratégico de la IA y su aplicación a soluciones de software de marketing bajo demanda o en modo SaaS.

Actualidad.

Ya se puede acceder a la versión completa de o3, el modelo razonador más avanzado del mercado entrenado para pensar por tiempo más largo. Esta es la versión que se anunció en diciembre y que hacía funcionar a DeepResearch pero que no podíamos usar directamente. Y OpenAI ha dado acceso también a una versión mini de su evolución, o4. Y todos los que lidiamos con estos modelos en el día a día, estamos -de nuevo- con la boca abierta. Algunos están jugando al geo-guessing, pero lo más alucinante es cómo esta forma de razonar evita alucinaciones y responde de manera correcta a preguntas más complejas, que requieren pensamiento estructurado y más sofisticado. Y se vuelve a hablar, claro, de AGI. Aunque mucha de la gente que usa ChatGPT (Altman presumía recientemente que ya lo hace el 10% de la población mundial) no tiene ni idea de lo que es la “g” en AGI, ni distingue entre la “o” de ChatGPT 4o y la “o” de o3. Al ritmo que vamos, esto podría convertirse en la versión moderna de “no saber hacer la o con un canuto”. OPENAI, AGI

Grok también es ahora multimodal: con Grok Vision podemos apuntar con la cámara del móvil (de momento solo en iOS) a objetos o documentos y hacer preguntas. También incorpora audio en múltiples idiomas y búsquedas con voz en tiempo real. LINK

Anthropic ha analizado 300.000 conversaciones para entender los valores morales de Claude. Los usuarios tienden a pedir comportamientos más arriesgados y prefieren asistentes menos cautelosos y más directos que los idealizados por los equipos de ética. ANTHROPIC

Algunos clubes ingleses están empezando a utilizar IA para crear perfiles psicológicos de los futbolistas de élite. Más allá de las estadísticas habituales, la IA analiza miles de horas de vídeo para detectar gestos sutiles y lenguaje corporal que revelan rasgos como la confianza, la agresividad o el liderazgo bajo presión. La personalidad en el campo se añade como una nueva variable a la hora de optimizar el rendimiento o planificar los fichajes. THE GUARDIAN

Reflexiones.

Antes de un año habrá empleados IA trabajando en algunas compañías, según predice el CISO de Anthropic, Jason Clinton. Los trabajadores virtuales tendrán su propia identidad corporativa (cuentas, correos, contraseñas, recuerdos), y serán mucho más independientes y capacitados que los agentes actuales. Clinton ve este campo como un enorme semillero de innovación, aunque también traerá nuevos desafíos de seguridad, como la gestión de privilegios, la monitorización del acceso y la determinación de responsabilidades. AXIOS

La resistencia a la IA en algunos ámbitos se basa en la creencia cultural que equipara valor y esfuerzo: si cuesta producirlo, es más valioso, y viceversa. Una asunción que se remonta a la época puritana, cuando se equipara trabajo y virtud. Algunos piensan que si es fácil, es trampa. Pero quizá deberíamos fijarnos en los resultados, y no en el proceso. La IA no elimina el trabajo, sino que lo redefine. Y siguen siendo imprescindibles las capacidades humanas (hacer mejores preguntas, ver conexiones, aplicar juicio, construir relaciones, imaginar posibilidades) para extraerle el máximo partido. LINK

La idea de que los LLMs constituyan por sí mismos una ventaja competitiva significativa está cada vez más cuestionada. Los verdaderos diferenciadores (moats) son otros: el talento, la percepción de la marca y el uso que se hace de los datos. LINK

Research.

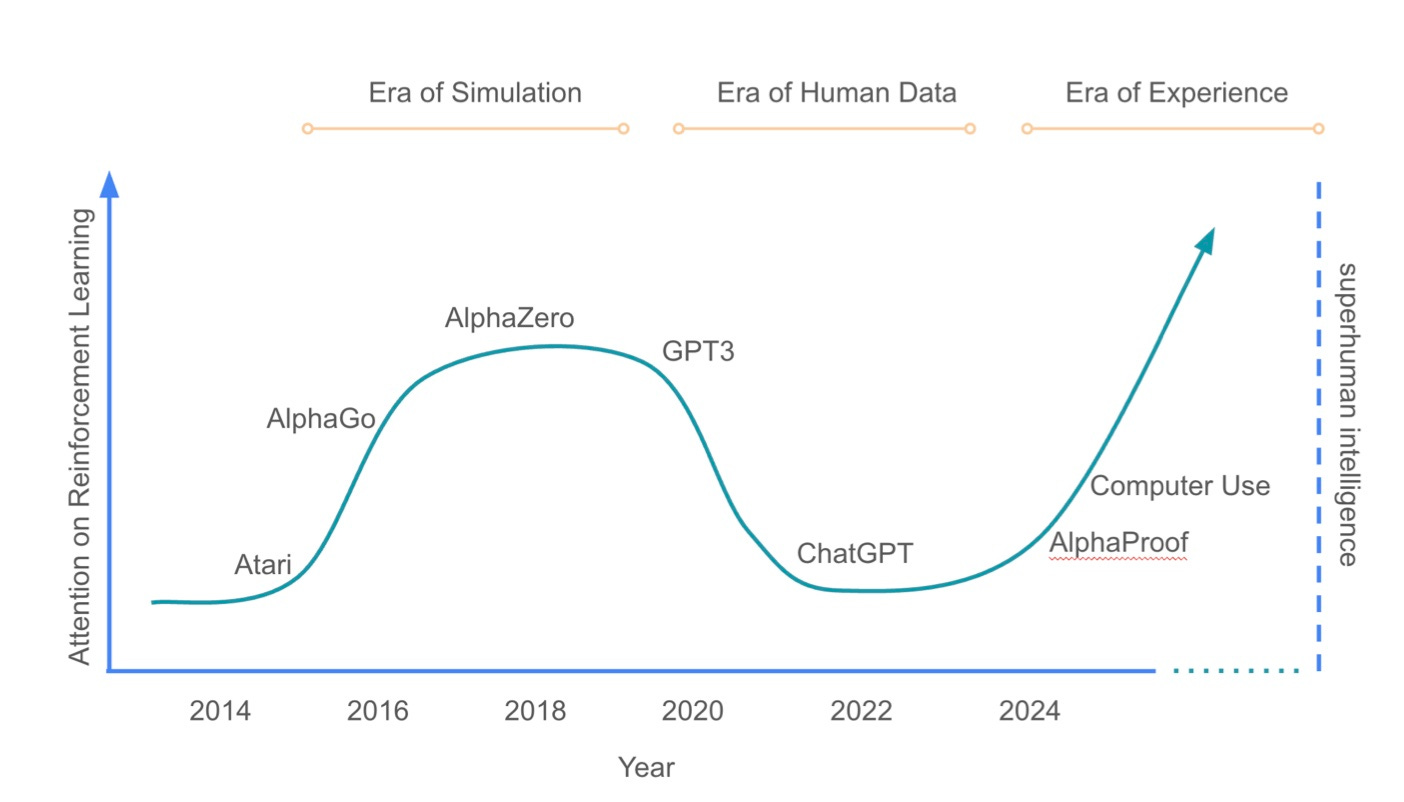

Investigadores de DeepMind introducen en Welcome to the Era of Experience una nueva arquitectura denominada "flujos" (streams), donde los agentes IA aprenden mediante la interacción continua con entornos dinámicos. En lugar de depender de los datos proporcionados por el entrenamiento humano, la IA aprendería de las interacciones con el mundo real y la retroalimentación con el entorno. Esto podría desbloquear para la IA capacidades aún más avanzadas, y encontrar de manera autónoma soluciones y descubrimientos más allá de los límites que marca el conocimiento humano.

Microsoft apunta a un futuro laboral híbrido en su estudio 2025 Work Trend Index Annual Report, en el que explora el concepto de Frontier Firm: un nuevo tipo de organización que se estructura en torno a la inteligencia a demanda (la IA como recurso accesible, escalable y asequible), equipos mixtos de humanos y agentes IA, y nuevos roles de liderazgo: agent boss, donde los líderes deben gestionar y colaborar con agentes IA por el bien común de la empresa. ZDNET

Un estudio del FMI nos recuerda que debemos mantener la alerta por el impacto medioambiental asociado al desarrollo de la IA, pero sin entrar en pánico. El FMI calcula que las emisiones de gases contaminantes entre 2025 y 2030 resultantes de la expansión de la IA serán de 1,7 Gigatoneladas con las politicas actuales (más o menos la misma cantidad de gases que emitirá un pais como Italia en ese periodo), o de 1,3 GTs si se utilizan más energías renovables. En cualquier caso, el FMI cree que las ganancias derivadas de la IA compensarán sobradamente este perjuicio. REUTERS

MCX.

Las agencias publicitarias están adoptando rápidamente deep research para optimizar los flujos de trabajo y mejorar la generación de información. Se nos olvida que apenas hace dos meses no existía. Hoy es difícil enfrentarse a una propuesta comercial sin usarlo. O preparar una conferencia o escribir un artículo en Rebel Intel :-) Claude ya ha lanzado el suyo, Perplexity lo da gratis, ChatGPT Plus amplía el uso a más usuarios (y lanza versión “lite”). DeepResearch nos hace parecer más listos a todos. Ahora sólo queda leerse las miles de palabras con sentido que estos agentes vomitan, y hacernos más listos de verdad. DIGIDAY

Bain llama agentes a lo que aún son asistentes, pero apunta con razón a lo que todos apuntamos: la intermediación de estos motores de IA entre consumidores y marcas cambia las reglas de juego. Curiosamente, mientras el marketing tradicional apela a emociones, los agentes privilegian datos estructurados y métricas verificables. BAIN

Y seguimos con la intermediación de los LLMs. Una investigación de Ahrefs analiza 300.000 keywords y concluye que la presencia de IA Overview en SERP reduce un 34% la tasa de cilcs, ya que muchos usuarios se quedan con el resumen que elabora la IA. Esto otorga a las plataformas, y no a los editores, el control de la visibilidad y el valor. LINK

Crear un avatar ya está al alcance de cualquiera. Aún es necesario mejorar aspectos como la consistencia de los personajes, la expresividad facial y la interacción en tiempo real, pero estas creaciones son cada vez más realistas y generan menos efecto de rechazo. En a16z exploran su evolución y diversos usos para los avatares creados por consumidores, pymes o grandes empresas. A16Z

Los profesionales del marketing recurren cada vez más a herramientas IA para replicar las funcionalidades de costosas aplicaciones martech, automatizando tareas como el análisis de datos y la creación de contenido. Esta tendencia obliga a los proveedores de SaaS martech a destacar sus propuestas de valor únicas, mejorar la experiencia del usuario e integrar la IA de forma innovadora para no quedar obsoletos. MARTECH

Entre lo que he leído esta semana y lo que compartís vosotros, acabo con la sensación de que en poco tiempo será la IA quien interactúe con nosotros y no al contrario. ¯\_(ツ)_/¯

muy bien explicado ;)