Responsabilidad sin fricción: claves para una IA segura en marketing y CX.

No se trata solo de usar bien la IA, sino de entender sus riesgos y la regulación inminente. En MCX, responsabilidad no es un valor: debe ser un sistema operativo.

En el contexto del Movimiento Nexo y junto a LinkedIn España, en Good Rebels hemos analizado cómo las grandes compañías están activando su galaxia de voces internas para generar confianza, conversación e impacto real.

En el I Estudio sobre la Cultura de la Conexión en la gran empresa española descubrimos que Repsol lidera con una alta dirección que toma la palabra sin filtro; que Mango y El Corte Inglés entienden LinkedIn como un espacio de diálogo, no de postureo; que Acciona o Insud Pharma usan la plataforma como imán de talento; y que Santander brilla por su visión holística, alineando propósito y narrativa con un liderazgo que comunica y moviliza. Este informe es más que un ranking: es una guía para transformar la comunicación corporativa desde dentro, con datos, casos reales y un framework que te servirá para pasar del ruido al impacto.

👉 Descarga el informe completo aquí

El avance de la Inteligencia Artificial en los departamentos MCX es indiscutible. Pero mientras creamos campañas hiperpersonalizadas, desplegamos chatbots 24/7 y medimos el sentimiento del cliente, existe el riesgo de que bajo la efervescencia tecnológica se esconda un vacío preocupante: la ausencia de una gobernanza robusta que asegure el despliegue responsable de la IA.

En ninguna otra área de la empresa es más necesaria una gobernanza de la IA meticulosa que en MCX, en primera línea de conexión con los clientes. La IA utiliza datos sensibles para la personalización, la segmentación y la predicción de tendencias. Al generar contenidos, responder en chatbots o elaborar programas de fidelización, estamos confiando en la IA todo tipo de estrategias persuasivas. Una IA mal gestionada conlleva el riesgo de distorsionar la voz de la marca, propagar desinformación o reaccionar de manera inapropiada, con el consiguiente daño reputacional.

Según IBM, apenas un 24% de las organizaciones que implementan proyectos de IA generativa tienen todos los riesgos bajo control, pese a que el 82% de los directivos considera que una IA segura y fiable es esencial. Además de las ya conocidas, la IA incorpora amenazas nuevas (por ejemplo, la manipulación de los modelos para acciones maliciosas). Por ello es importante mantener actualizados los modelos de gobernanza, riesgo y cumplimiento en todo el ciclo de vida de la IA, y garantizar la seguridad de infraestructuras, datos y uso de los modelos.

IA responsable: orquestando con propósito.

¿Qué entendemos por IA responsable? Podríamos definirla como un conjunto de reglas, prácticas y procesos que una organización establece para asegurar que sus sistemas de IA se desarrollan y utilizan de manera ética, segura y alineada con sus objetivos y valores. Garantizar un uso ético de la tecnología, promover la transparencia y la equidad en sus aplicaciones, cumplir las normativas vigentes y fomentar la innovación de manera responsable. No es un mero ejercicio de compliance: es el andamiaje sobre el que se construye confianza, se mitigan riesgos y, en última instancia, se extrae valor duradero de la IA.

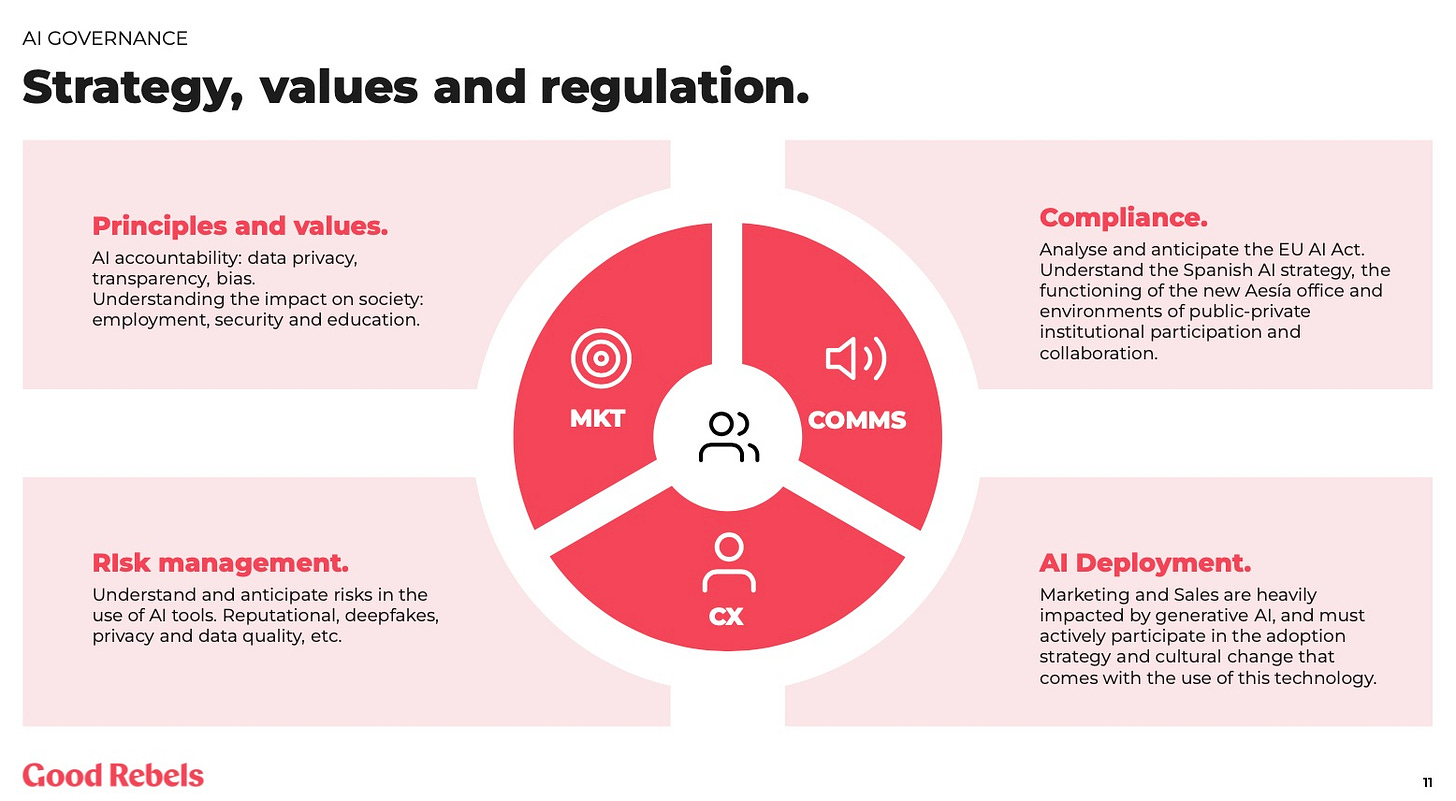

Bajemos a la arena MCX, donde la gobernanza trasciende ese planteamiento genérico y se convierte en un imperativo claro que aplicar en el día a día. Siguiendo la metodología desarrollada en Good Rebels y que también usamos desde el Foro IA, podemos agrupar sus componentes clave en cuatro áreas:

Principios y valores: el norte ético que alinea la IA con los valores fundamentales de la marca. Esto implica definir umbrales claros para la personalización (¿Dónde acaba la relevancia y empieza la intromisión?), asegurar la transparencia en el uso de datos del cliente y combatir activamente los posibles sesgos en la segmentación o las recomendaciones. En la práctica: ¿usamos chatbots que informan claramente de su naturaleza artificial? ¿Auditamos nuestros algoritmos de targeting para evitar discriminaciones? ¿Nuestra política de privacidad refleja fielmente cómo la IA procesa los datos del cliente?

Cumplimiento: navegar el complejo y cambiante panorama legal, desde marcos regulatorios amplios hasta normativas sectoriales o nacionales. Implica entender las obligaciones sobre el tratamiento de datos, el consentimiento, la explicabilidad de las decisiones algorítmicas, todo ello vinculado a los derechos de los consumidores. ¿Nuestras campañas automatizadas cumplen con las normativas de consentimiento? ¿Podemos explicar por qué un cliente recibió una oferta específica generada por IA? ¿Estamos preparados para las nuevas exigencias de transparencia de la nueva ley europa de IA en nuestras comunicaciones?

Gestión de riesgos: creamos la red de seguridad que nos permite identificar, evaluar y mitigar los riesgos específicos de la IA en cada punto de contacto con el cliente. Aquí se incluye el posible perjuicio de un chatbot mal calibrado, el impacto de deepfakes en la credibilidad de la marca, la seguridad de las plataformas de IA que manejan datos de clientes o una experiencia de cliente deteriorada por una automatización deficiente. ¿Tenemos protocolos para validar el contenido generado por IA antes de publicarlo? ¿Monitorizamos las interacciones de nuestros sistemas IA con los clientes para detectar sesgos o errores? ¿Contamos con planes de contingencia específicos para incidentes relacionados con IA?

Despliegue: implica integrar activamente la IA en la estrategia global de MCX, asegurando que los equipos no solo usen las herramientas, sino que participen en su selección, implementación y evaluación. Requiere fomentar una cultura de experimentación responsable y superar la resistencia al cambio mediante formación y comunicación claras. ¿Están involucrados los equipos MCX en la definición de los casos de uso de IA? ¿Lanzamos proyectos piloto para testear aplicaciones IA antes de un despliegue masivo? ¿Estamos invirtiendo en upskilling?

Una gobernanza de IA eficaz no va de aplicar políticas. El verdadero impulsor es la cultura. La gobernanza requiere compromiso desde el liderazgo, colaboración entre áreas (MCX debe trabajar codo con codo con Legal, IT y Datos), formación continua y fomentar un entorno de diálogo y debate, donde se puedan plantear todo tipo de preocupaciones éticas.

El laberinto regulatorio y ético.

El panorama regulatorio global para la IA es diverso y fragmentado, con enfoques que difieren en las grandes jurisdicciones. En la UE, la Ley de IA establece un sistema de clasificación de riesgos desde inaceptables hasta mínimos, con diferentes requisitos de cumplimiento para cada nivel. Las prohibiciones a prácticas consideradas inaceptables entraron en vigor en febrero de 2025, mientras que las obligaciones para los sistemas de IA de propósito general, como los chatbots, comenzarán en agosto de 2025. El incumplimiento de la Ley puede acarrear multas de hasta 35 millones de euros, o el 7% de la facturación global de una empresa.

En Estados Unidos, no existe una ley federal sobre la IA, pero existe una creciente actividad a nivel estatal, con leyes promulgadas en California y Colorado, entre otros. A nivel federal, la Orden Ejecutiva emitida por el presidente Biden en octubre de 2023 marcó un hito importante. Sin embargo, en enero de 2025 la Administración Trump emitió una nueva orden que suprimió políticas federales clave de supervisión de la IA establecidas por sus predecesores.

Otras iniciativas globales incluyen la creación de regulaciones y grupos de trabajo en países como Australia, India, Emiratos Árabes Unidos, Canadá y Brasil. Además, existen varios marcos éticos y principios que buscan guiar el desarrollo y la implementación de la IA de manera responsable, como las recomendaciones de la UNESCO, los Principios de la OCDE sobre la IA, el Marco de Ética de la IA de IBM, o los Principios de IA Responsable de Microsoft.

Esta falta de estándares crea complejidad para las empresas multinacionales. Pero lo que está claro es que el futuro será regulado. Habrá cada vez más énfasis en la auditoría, la supervisión y la explicabilidad de la IA desde el diseño. Adoptar proactivamente un marco de gobernanza robusto es fundamental para prepararnos. A menudo persisten focos de resistencia a la gobernanza, más por razones culturales que técnicas. El miedo a la burocracia, el desconocimiento de los riesgos reales, la percepción de que la regulación frena la agilidad o la ausencia de un liderazgo claro son obstáculos a las políticas de gobernanza. Para superarlos se requiere un esfuerzo conjunto de comunicación y formación y, sobre todo, demostrar el valor estratégico de una gobernanza bien entendida.

Aprendiendo de los líderes: rasgos de una gobernanza efectiva.

El Responsible AI Institute nos recuerda las cuatro características que distinguen a las empresas que integran la gobernanza en el core de su negocio:

Tratan la gobernanza como una función empresarial: no la consideran una formalidad o una respuesta reactiva a las regulaciones. Han establecido estructuras formales—como políticas, comités de revisión y registros de riesgos—que definen cómo se desarrollan, evalúan y mantienen los sistemas de IA. Utilizan marcos y estándares independientes para evaluar su progreso y prepararse proactivamente para cambios regulatorios, lo que les permite cumplir con nuevas leyes sin sobresaltos.

Definen claramente la rendición de cuentas: la tecnología no se gobierna por sí sola. Estas organizaciones asignan responsabilidades específicas a individuos o equipos en cada etapa del ciclo de vida de la IA. Implementan formaciones prácticas y continuas adaptadas a cada función, asegurando que todos comprendan su papel en la gobernanza de la IA. Además, la alta dirección se involucra activamente.

Diseñan para generar confianza desde el inicio: desde las primeras etapas de desarrollo, estas empresas integran principios de equidad, privacidad y explicabilidad en sus sistemas de IA. Utilizan herramientas como evaluaciones de impacto ético y pruebas de sesgo para garantizar que los sistemas sean confiables y transparentes. La transparencia es una estrategia para construir relaciones sólidas con clientes, empleados y reguladores.

Crean incentivos internos: más allá de cumplir con regulaciones externas, estas organizaciones fomentan una cultura interna que valora la responsabilidad en el uso de la IA. Implementan métricas específicas para evaluar la responsabilidad en la IA y vinculan estos indicadores con los objetivos empresariales. Algunos incluso incorporan estos criterios en evaluaciones de desempeño y decisiones de inversión, asegurando que la responsabilidad en la IA sea una prioridad compartida en toda la organización.

No pensemos en la gobernanza como algo que se relega al departamento legal o IT. Es una parte integral de la estrategia central para cualquier organización. En última instancia, una buena gobernanza de IA se traduce en beneficios para el cliente: interacciones más seguras, menor exposición a sesgos o discriminación, mayor protección de su privacidad, personalización relevante pero respetuosa, y mecanismos claros para recurrir si algo va mal. La gobernanza construye relaciones basadas en la confianza, no solo en la transacción.

El próximo domingo, volvemos a tu buzón.

Fernando y Carlos.

Otra semana de locos participando en eventos alrededor de la IA. Arrancaba el martes en Barcelona, impartiendo una conferencia en Cellnex y reflexionando sobre el uso que se puede hacer de la IA en su particular contexto B2B. Muy interesante y enriquecedora la visión multicultural de un equipo de comunicación al completo, presentes en 10 países europeos. En el Congreso de CIOs de la APD del miércoles, hablábamos de cómo preparar a las empresas para una interfaz máquina a máquina, si nuestros clientes ya no son personas sino sus agentes de compra. El jueves, con el Club de Marketing de ESADE, les contaba mi retrato robot del consumidor en el 2030. El viernes, hablé en Sevilla en el Congreso de AIMFA sobre cómo será trabajar en marketing y ventas en la industria farmacéutica en 4 años. Spoiler: ¿quién sabe? Y remataba el sábado mi participación en el Programa de Dirección de Comunicación del IE que esta semana versaba sobre IA en MCX. Poco nuevo cuando todo es nuevo, más allá de “actualizar traspas” y mucho veo 3 :) Y por último, un resumen en vídeo del evento del Foro IA y AMKT de la semana pasada.

Actualidad.

ChatGPT everywhere? En los Emiratos Árabes, ChatGPT se va a integrar en servicios públicos (aunque no será gatuito para toda la población, como se ha rumoreado) para utilizarse en aplicaciones gubernamentales, escuelas o portales de atención médica. Es parte del programa OpenAI for Countries, que pretende que cada país tenga una especie de versión local de ChatGPT. OpenAI también empieza a explorar el inicio de sesión en aplicaciones de terceros utilizando la cuenta de ChatGPT. LINK

Meta está reestructurando sus equipos de IA para acelerar el lanzamiento de nuevos productos y funciones. A partir de ahora, habrá dos divisiones: AI Products será responsable del asistente IA y de las funcionalidades IA para Facebook, Instagram y WhatsApp. La unidad AGI Foundations se ocupará del desarrollo de Llama y las mejoras de las capacidades de razonamiento, multimedia y voz. (Pero según Business Insider, Meta está perdiendo a sus mejores talentos IA, muchos con destino a Mistral en París. Solo 3 de los 14 firmantes del paper original de Llama siguen en la compañía). AXIOS

El New York Times y Amazon han llegado a un acuerdo para que el gigante tecnológico utilice el contenido editorial del periódico en sus plataformas de IA. Esto permitirá a Amazon usar resúmenes y extractos del Times en productos como Alexa, y también para entrenar sus modelos de IA. CNN

IA a la europea. Capgemini se ha aliado con SAP y Mistral para ofrecer soluciones de IA generativa a industrias reguladas y con estrictos requisitos de datos, como finanzas, defensa y energía. Usarán los modelos de Mistral con la plataforma de SAP para desarrollar casos de uso de IA, permitiendo a las empresas simular escenarios y adaptarse rápidamente a los cambios del mercado. LINK

Reflexiones.

La presentación anual de Benedict Evans repite el título del año pasado: AI eats the world. LINK

¿Qué significa que una empresa se declare AI-first, como ya han hecho Duolingo, Shopify y Box? Apunta a una transformación profunda, donde la IA se convierte en el principio rector de su estrategia y operaciones. Pero no hay que descartar otras implicaciones: tal vez se trata de mandar un mensaje a los inversores, o de atraer el talento más valioso en mercados súper competitivos. En cualquier caso, hay que ser muy cuidadoso con esta proclama, y dejar claro que el AI-first no pasa por encima del human-first. LINK

Y al respecto, Kevin Roose y el New York Times vuelven a tratar señales alarmantes de paro juvenil de cuello blanco ¿debido a la IA? No deja de ser inquietante, pero me sigue pareciendo pronto para extraer conclusiones claras. NYT

Duelo de titanes: Claude 4 Opus vs Gemini 2.5 Pro vs Open AI o3. Una comparativa sin benchmarks: su capacidad de programación frente a frente, con tareas concretas. ¿El veredicto? Claude 4 es el más completo generando código, Gemini gana en la relación calidad / precio, y o3 queda en todo en un nivel intermedio. LINK

No he sido capaz de entender (ni terminar) este largo artículo de la cofundadora de Thinking Machines sobre los mecanismos que están consiguiendo hacer razonar y pensar a la IA más avanzada. Pero lo guardaré como oro en paño por si un día me conecto a una IA superior. LILIAN WENG, PODCAST

Cómo la IA está cambiando el uso de las herramientas de ligoteo. DAZED

Research.

Más sobre agentes: ¿cómo es su relación con la publicidad online? Lógicamente, desdeñan los elementos visuales diseñados para captar la atención humana. Pero cuidado, porque no ignoran completamente los anuncios. Una investigación sobre el comportamiento de GPT-4o, Claude 3.7 y Gemini 2.0 Flash concluye que se fijan en datos estructurados y palabras clave de los anuncios. La publicidad digital futura deberá adaptarse a esta priorización de la información por encima de los elementos visuales. LINK

Un estudio de Gallup revela cierta desconexión entre la visión corporativa sobre la IA y la de los empleados. Mientras que la mayoría de los directores de RRHH (93%) de grandes empresas afirman estar integrando la IA, solo un tercio de los empleados es consciente de que está integrada en los procesos operativos, y un 67% no la usa nunca. La falta de comunicación clara y la escasa formación específica generan incomodidad entre los trabajadores. GALLUP

State of AI in the Enterprise. Por BOX

MCX.

¿Qué implicaciones para la industria publicitaria tiene la introducción del modo IA en las búsquedas de Google? Diferentes expertos responden a esta pregunta, todo un desafío para los ingresos de publishers y retailers. Se espera una disminución en los clics y una reasignación de los presupuestos publicitarios. La industria debe adaptarse a un modelo conversacional, donde la información del producto actualizada y de alta calidad es crucial para la visibilidad de marca y la construcción de autoridad. LINK (Y también: ganadores y perdedores con AI Mode).

Y sobre los anuncios de Google, uno que no debe pasar desapercibido. El virtual try-on con el que nos podemos probar cualquier trapito subiendo una foto nuestra. GOOGLE

Perplexity lleva medio año insertando anuncios, y algunos anunciantes ya están pidiendo más escala. Los formatos publicitarios son limitados (enlaces de texto en los resultados), pero es interesante llegar a usuarios con alta intención informativa. La pregunta es si Perplexity logrará crecer lo suficiente para convertirse en una plataforma publicitaria relevante, o si se quedará como una curiosidad para nichos específicos. LINK

Esta semana lo han petado los vídeos prompt theory, en los que todo tipo de personajes (creados con Veo 3) debaten si han sido creados o no con un prompt. Tiene su punto. YOUTUBE

Off Tópicos.

En The End of The Twitter Era, Noah Smith reflexiona sobre el declive de Twitter / X como la principal plataforma para noticias de última hora y debate. Aunque Twitter fue crucial en la década de 2010 por su apertura y capacidad para informar rápidamente sobre eventos, su utilidad ha disminuido debido a los cambios introducidos, el abandono de muchos usuarios y la pérdida de incentivos para reportar noticias en tiempo real. Noah cree que Substack tiene el potencial de ocupar este vacío, enfocándose en un modelo de "periodismo ciudadano" más curado y sostenible a largo plazo. NOAH SMITH

YouTube hace tiempo que ha dejado atrás su imagen de cajón de sastre para vídeos caseros, y ahora aspira a convertirse en la nueva televisión, atrayendo audiencias masivas y, lo más importante, anunciantes. Creadores como Alan Chikin Chow están produciendo contenido más largo, incluso sitcoms, optimizadas para la pantalla grande del salón y dirigidas a jóvenes… y no tan jóvenes. LINK

Tras leerlo, la palabra que se repite mucho es "formación", mucho que profundizar por esa vía con la IA